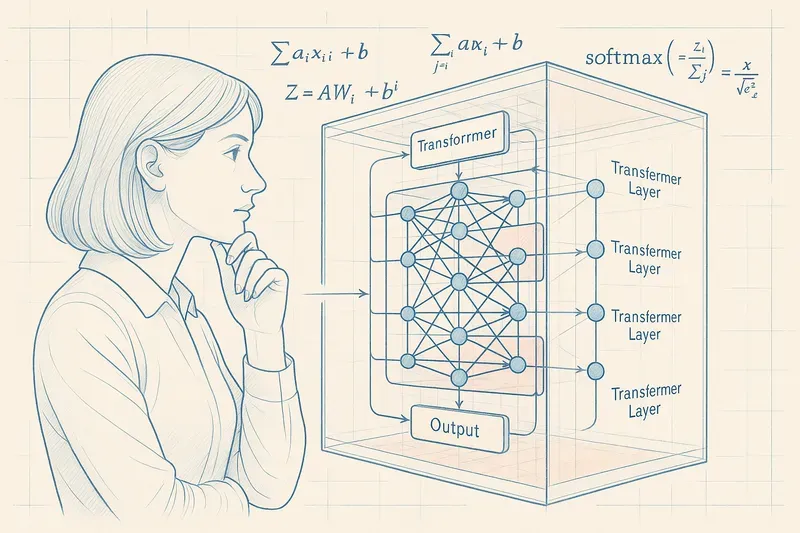

Dans un récent papier (« Learning without training: The implicit dynamics of in-context learning »), les équipes de Google proposent une plongée mathématique dans les entrailles des Transformers.

Petit rappel technique rapide

Un LLM, ce sont des couches de Transformer empilées. Dans chaque couche, on retrouve deux blocs principaux :

- La Multi-Head/Self-Attention : ce mécanisme permet au modèle d’évaluer l’importance relative de chaque mot par rapport aux autres, pour capter le contexte.

- Le réseau Feed-Forward (FFN) : une étape de traitement plus dense où l’information est transformée en profondeur via des fonctions d’activation, qui modulent l’intensité du signal de chaque neurone.

Mais ce qui est fascinant, c’est que l’interaction entre ces couches ne se limite pas à un simple traitement séquentiel.

La découverte : une plasticité dynamique

Le papier démontre que le passage dans le FFN, combiné au contexte amené par l’attention, revient mathématiquement à créer temporairement une matrice de poids spécifique à l’entrée. En clair, l’architecture permet une adaptation dynamique à chaque situation, une forme de plasticité temporaire, uniquement déclenchée par le prompt.

Même avec des poids figés, le modèle semble s’adapter en temps réel à chaque nouvelle entrée. Une forme d’intelligence contextuelle !

La démonstration (non encore validée par les pairs) vise à mieux comprendre cette boîte noire, pour développer à terme des techniques de diagnostic, d‘“explicabilité”, et même d’optimisation ciblée.

Les perspectives ouvertes

Ce cadre formel ouvre plusieurs pistes concrètes :

- Concevoir des mécanismes d’inférence conditionnée, pour une adaptabilité sans fine-tuning.

- Tester des architectures hybrides et modulaires, en lien avec des approches comme les Hyper-Networks ou les Mixtures-of-Experts.

- Et, pourquoi pas, avancer vers une théorie unifiée des LLMs – qui expliquerait enfin pourquoi ça marche aussi bien.

Attention cependant à ne pas confondre description mathématique et compréhension profonde : ces observations doivent être le point de départ, pas l’aboutissement, de notre compréhension des LLMs.

Conclusion

Bref, les modèles sont puissants, mais c’est encore l’intelligence humaine qui devra en tirer tout le potentiel.

Le coin des experts 🤓

Mixtures-of-Experts (MoE)

Définition technique : Une architecture dans laquelle plusieurs sous-modèles (“experts”) sont disponibles, mais seuls quelques-uns sont activés pour chaque entrée, selon un mécanisme de sélection (gating), permettant de spécialiser les calculs tout en maîtrisant les coûts.

Avantages :

- Réduction significative des coûts de calcul

- Spécialisation adaptative selon le contexte

- Scalabilité améliorée

Exemple concret : Un modèle MoE pourrait avoir des experts spécialisés dans différents domaines (médecine, code, littérature) et n’activer que les plus pertinents selon la tâche.

Hyper-Networks

Définition technique : Un réseau qui ne fait pas de prédictions directement, mais qui génère dynamiquement les poids d’un autre réseau principal, permettant à ce dernier de s’adapter à chaque tâche ou contexte sans entraînement supplémentaire.

Applications potentielles :

- Adaptation rapide à de nouveaux domaines

- Personnalisation sans réentraînement

- Méta-apprentissage efficace

Analogie : Un chef qui adapte sa recette en temps réel selon les ingrédients disponibles, sans avoir besoin de réapprendre à cuisiner.

AiBrain

AiBrain