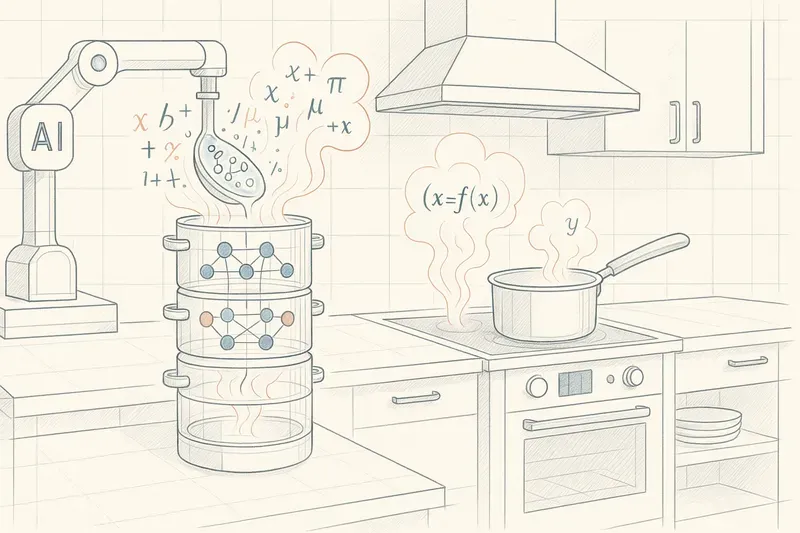

Vous êtes-vous déjà demandé comment fonctionne un modèle comme GPT ? Oubliez les lignes de code complexes et imaginez-vous en cuisine. Voici la recette d’un LLM réussi, expliquée comme un plat de haute gastronomie algorithmique.

Vous aurez besoin de :

- Beaucoup de textes variés (livres, articles, conversations… même un peu d’Asimov), l’équivalent de 3 millions de dictionnaires.

- Un grand panier de mots et de fragments (du “chat” au “miaule” en passant par “ronronne” et “curieux”).

- Un distillateur d’arômes multicouche (couches de neurones transformeurs) : chaque couche agit comme un extracteur d’arômes de pointe, analysant minutieusement les mélanges de mots. Elles décomposent l’information brute, filtrent ce qui est moins pertinent et isolent les “molécules de sens” cruciales, révélant ainsi les liens et les saveurs cachées entre les mots.

- Une pincée d’attention (pour marier les saveurs).

- Un four à micro-lots (pour cuire progressivement, comme un pâtissier patient).

Étape 1 : Hacher le texte (Découpage)

Prenez tous les mots présents dans le texte et associez-leur à chacun un identifiant ; au besoin, coupez-les s’ils sont trop longs (comme “chocolat”, qui peut se séparer en “choco” et “lat”).

Étape 2 : Faire mariner les morceaux (Embeddings)

Plongez la portion “chat” dans une marinade aléatoire à 1 536 saveurs (une longue liste de nombres mystérieux), qui va permettre d’en capter toutes les caractéristiques.

Étape 3 : Créer des mariages de saveurs (La mécanique d’attention)

Il est temps d’ajuster la marinade de chaque mot. Dans la phrase “Le chat dort sur le tapis alors que la fusée décolle.”, chaque mot va être relié aux autres. Au fur et à mesure des cuissons, certains mots vont se rapprocher, comme “chat” et “dort” : un accord parfait, comme miel et citron. “Chat” et “tapis” obtiendront aussi un accord correct, comme fromage et vin. “Chat” et “fusée”, par contre, ne se marieront pas bien, comme eau et huile, même s’ils sont présents ensemble dans cette phrase. Ce processus, répété pour chaque mot de nombreuses fois, tisse des relations sémantiques profondes : “chat” s’associe naturellement à “ronronne” ou “fourrure”, mais s’éloigne de “Xfile”.

Étape 4 : Cuire par petits lots (Entraînement)

Prédire, goûter, ajuster : le secret d’un plat réussi façon haute gastronomie algorithmique. On va associer notre énorme bibliothèque en paquets de 512 phrases, et faire deviner au modèle le prochain mot de la phrase. Si, pour la phrase “le chat miaule”, la prédiction est “le chien aboie”, alors on va ajuster les réglages du distillateur multicouche et la marinade de “miaule” pour qu’elle se retrouve préférentiellement derrière le mot chat. Recommencez des milliers de fois, jusqu’à ce que les saveurs de tous les mots soient parfaitement équilibrées.

Étape 5 : Décorer avec la génération (Dressage à l’assiette)

Demandez à votre LLM préféré “Raconte-moi une histoire de chat.” Le modèle va piocher dans les arômes de “chat” et trouver des liens avec « curieux », « souris », « nuit » ; il ajoute un soupçon de choix aléatoires et l’histoire surgit : “Un chat nommé Pixel adorait explorer les toits…” Servez tiède.

Conclusion : Le Plat Final 🍲

GPT, c’est une soupe de mots mijotée :

- Découpés en unités,

- Marinés en arômes numériques,

- Liés par des mariages de saveurs,

- Cuits par lots.

Comme le dit souvent Auguste Gusteau : “Tout le monde peut coder… mais seul un bon modèle sait raconter une bonne histoire de chat.”

Le coin des experts 🤓

Vous entrez dans la “Nerd Zone” — l’entrée n’est pas interdite au grand public, mais la sortie n’est pas garantie !

Transformers / Distillateurs sémantiques

Définition technique : Les Transformers sont une architecture de réseaux de neurones, introduite par Vaswani et al. en 2017. Leur grand atout est de pouvoir traiter un texte entier en parallèle grâce au mécanisme d’attention, contrairement aux réseaux précédents (RNN, LSTM) qui avançaient mot à mot.

- La dimension interne du modèle ($d_{model}$) : À l’intérieur de ces distillateurs, l’information est traitée dans un “espace” de très haute dimension. C’est la largeur des couches de neurones. Plus cette dimension est grande, plus le modèle peut manipuler et comprendre de nuances et de relations complexes entre les mots.

- Impact : Cette architecture a révolutionné le traitement du langage (et même de l’image), permettant aux modèles de capturer des relations sémantiques très complexes sur de longs textes.

- Analogie : Imaginez une batterie d’alambics (distillateurs) sophistiqués, capables d’extraire les “molécules de sens” les plus subtiles. La dimension interne du modèle est comme la complexité des circuits internes de ces alambics.

Unité / Morceau (Token)

Définition technique : Un token est l’unité de base traitée par un LLM. Ce n’est pas toujours un mot entier : il peut s’agir d’un mot, d’un morceau de mot (“choco” + “lat”) ou d’un caractère.

- À savoir : Plus un mot est rare ou long, plus il risque d’être coupé en plusieurs tokens. Un roman typique en français, c’est environ 700 000 tokens.

- Ordre de grandeur : GPT-3 a une “fenêtre de contexte” de 2 048 à 4 096 tokens. GPT-4 va jusqu’à 32 000, voire plus.

Embedding (Marinade numérique)

Définition technique : Un embedding est une représentation vectorielle d’un token. Chaque token est traduit en une longue liste de nombres (un “vecteur”) qui résume ses facettes sémantiques. Plus les vecteurs de deux mots sont “proches” dans cet espace numérique, plus leurs significations sont similaires.

- Ordre de grandeur : Les modèles GPT-3/4 utilisent des embeddings de 1 536 ou 3 072 dimensions.

- Analogie : C’est la marinade qui capte toutes les saveurs d’un ingrédient. Chaque nombre du vecteur est une “note” (parfum, texture, etc.).

Lot (Batch) / Four à micro-lots

Définition technique : Un batch est un ensemble de séquences de texte traité simultanément lors de l’entraînement pour optimiser l’utilisation du matériel (GPU/TPU).

- Taille typique : de 32 à 2 048 séquences.

- Analogie : Une fournée de petits gâteaux cuits ensemble pour optimiser le temps et l’énergie.

Attention / Mariage de saveurs sémantiques

Définition technique : Le mécanisme d’attention permet au modèle de peser l’importance de chaque mot par rapport aux autres dans une séquence.

- Types d’attention :

- Self-attention : chaque mot « regarde » les autres mots de la même séquence pour comprendre le contexte global.

- Cross-attention : permet à une séquence de s’aligner avec une autre (ex: texte et image), utile pour le multimodal ou la traduction.

- Poids d’attention : Un score élevé indique un lien sémantique fort (miel et citron), un score faible indique le contraire (eau et huile).

- Analogie : Un chef qui goûte chaque association possible pour ne garder que les accords parfaits.

Conclusion finale

Ce découpage arbitraire des mots en tokens — “chocolat” pouvant devenir “choco” + “lat” — permet certes au modèle d’apprendre à “deviner” avec brio, mais il met aussi en lumière sa limite fondamentale : un LLM n’a aucune conscience intime du sens. Il manipule des fragments de texte, pas des idées.

À l’heure où l’on fantasme sur l’émergence d’une “vraie” intelligence artificielle, il est essentiel de garder à l’esprit cette distinction : la prouesse technique est réelle, mais le chemin vers une compréhension humaine du langage reste, pour l’instant, un autre défi.

Il est aussi essentiel de garder à l’esprit que les LLM permettent à l’esprit humain de fonctionner dans des modes et des environnements nouveaux et différents, et que l’émergence de la nouveauté réside sans doute là.

AiBrain

AiBrain