Comme nous l’avons vu dans la partie 2, nous ne sommes pas encore arrivés à l’intelligence artificielle générale (AGI). Elle n’est même pas vraiment définie. Dans l’exercice d’aujourd’hui, nous allons donc l’envisager comme une montagne à gravir, dont le sommet est perdu dans la brume.

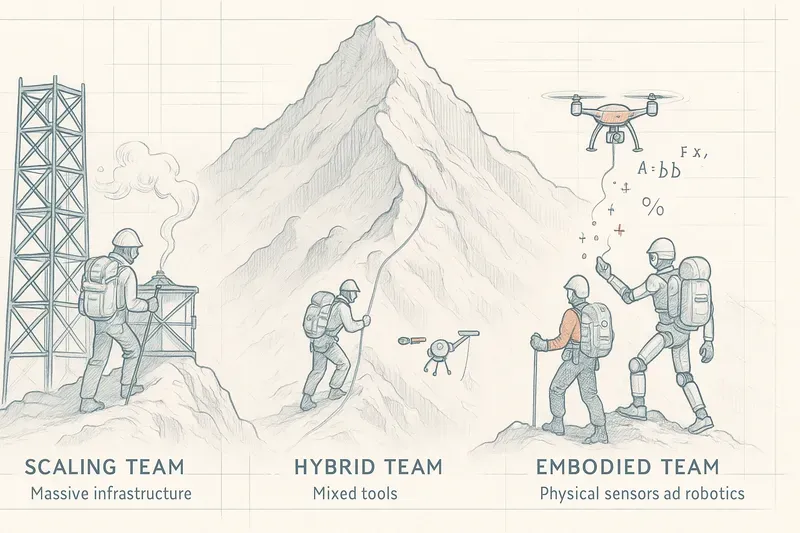

Nous voici donc au camp de base des IA conversationnelles modernes. Les premiers cols et pics de la montagne de l’IA sont déjà conquis. On retrouve maintenant trois grandes équipes, prêtes à poursuivre l’ascension.

Les équipes

Les Gros Bill du Cloud (la loi du plus)

Ils misent sur l’augmentation d’échelle des modèles actuels, et leur devise « toujours plus ». Au programme : plus de serveurs, plus de données, plus de temps, plus de paramètres… et une paire de lunettes de soleil pour ne pas être trop éblouis par la facture des coûts d’entraînement. Leur foi repose sur l’idée que la montée en complexité des modèles permettra l’émergence de nouvelles capacités, ouvrant la voie à une forme de raisonnement suffisamment avancée pour être qualifiée d’AGI.

Mais cette voie, aussi vertigineuse que séduisante, n’est pas sans gouffres. L’augmentation continue de l’échelle entraîne des coûts d’entraînement colossaux, une consommation énergétique exponentielle, et une dépendance à des infrastructures ultra-concentrées, réservant cette stratégie à une poignée d’acteurs capables de brûler des centaines de millions de dollars par itération. Et rien ne garantit que le simple fait de grossir encore permettra de franchir le cap du raisonnement abstrait, de la conscience de soi ou de l’adaptation contextuelle.

Les “hybridistes” (intuition et raisonnement)

L’approche symbolique est à l’origine des premiers outils d’intelligence artificielle : les systèmes experts. Ils reposent sur un ensemble de règles clairement définies et sont capables de traiter l’information en accord avec ces règles. Exemple : un système symbolique peut analyser un dossier médical structuré et en déduire des diagnostics possibles en appliquant un ensemble de règles cliniques.

Les hybridistes savent que les IA conversationnelles manquent de ce petit truc en plus : une véritable capacité de raisonnement au sens humain du terme. Leur objectif est d’associer la capacité des modèles de langage à reconnaître des motifs et à extraire des faits depuis des données non structurées, avec de véritables couches de raisonnement symbolique. Cette approche permet d’assurer la transparence des processus de décision.

L’approche hybridiste se heurte toutefois à la difficulté d’articuler des modèles statistiques flous avec des logiques symboliques strictes, rendant l’intégration souvent instable. En parallèle, le codage symbolique demande un travail manuel intensif : définir des règles, maintenir leur cohérence, et couvrir tous les cas utiles reste coûteux et difficilement transposable à grande échelle.

Les corporealistes (action-réaction)

Ici, pas de compromis : l’intelligence véritable ne peut être uniquement digitale. Il faut voir, sentir, interagir avec le monde physique pour faire partie des êtres éclairés. Chez les corporealistes, l’accent est mis sur l’apprentissage de l’IA incarnée à partir d’expériences vécues dans le monde réel. Les IA purement numériques se heurteraient inévitablement au «fossé de la réalité». La compréhension du monde réel, telle que la possèdent les humains, va bien au-delà des schémas de données abstraits. Elle nécessite un ancrage dans l’expérience sensorimotrice, une perception continue du corps et une capacité d’adaptation permanente.

Il est essentiel de comprendre que pour être véritablement incarné, un système ne peut pas se contenter d’être un robot. Il lui faut une conscience de son propre corps, une perception de son environnement, et la capacité de comprendre et d’agir en fonction de ce qu’il perçoit, en adaptant ses actions de manière autonome et contextualisée.

Mais cette voie, aussi incarnée soit-elle, n’est pas sans contraintes physiques bien réelles. Développer une IA qui apprend dans le monde implique de gérer des capteurs imparfaits, des temps de réaction parfois critiques, des environnements imprévisibles, autant de facteurs qui rendent l’apprentissage lourd, lent et coûteux. Contrairement aux modèles textuels, qui peuvent ingérer des milliards de données en quelques jours, une IA corporelle doit littéralement vivre chaque expérience, une à une, ce qui ralentit considérablement sa progression.

Les protagonistes dans la course à l’AGI : chacun sa voie

À ce stade de l’ascension, il ne s’agit plus seulement de groupes de chercheurs ou d’idées théoriques : les grandes puissances de l’IA sont désormais incarnées par des entreprises qui, chacune à leur manière, ont choisi leur voie pour gravir la montagne de l’intelligence artificielle générale.

OpenAI

Incarne à elle seule l’élan des “Gros Bill du Cloud”. Son approche est claire : augmenter l’échelle, toujours, encore, jusqu’à atteindre un point d’émergence où l’intelligence jaillirait d’elle-même. GPT-3, GPT-4, GPT-4o, autant de jalons vers ce sommet invisible. Mais une inflexion se dessine : avec GPT-4o, la voix, la vision, le dialogue en temps réel font leur apparition. OpenAI commence à sortir du pur texte, à explorer les premières logiques d’une incarnation logicielle sans franchir le pas de la robotique, mais en élargissant les sens.

DeepMind (Google)

La stratégie est plus feuilletée. Le scaling n’a pas été abandonné bien au contraire, Gemini et les travaux sur la loi de Chinchilla montrent leur maîtrise des grandes architectures. Mais DeepMind est aussi l’un des seuls à investir avec autant de sérieux dans l’intelligence incarnée, notamment avec PaLM-E, un modèle qui perçoit, comprend et agit dans le monde physique. Ajoutons à cela leurs expérimentations symboliques (comme AlphaCode) et l’on obtient une vision qui cherche à fédérer les trois approches, dans une forme d’unification scientifique ambitieuse.

Meta

S’est positionnée presque frontalement dans le camp des corporealistes. Chez eux, l’IA ne se limite pas à répondre à des questions, elle doit habiter le monde : voir à la première personne (Ego4D), naviguer dans des environnements complexes (Habitat), toucher et ressentir (avec DIGIT). Meta considère que la cognition commence dans les sens, et que l’AGI ne peut exister sans ancrage sensorimoteur. C’est un positionnement fort, encore peu visible dans leurs modèles de langage comme LLaMA, mais profondément structurant dans leur vision à long terme.

Anthropic

Leur approche, plus discrète et philosophique, se fonde sur la nécessité de rendre les modèles plus sûrs, plus compréhensibles, plus gouvernables. Avec Claude, ils poursuivent la logique du scaling, mais introduisent aussi des notions de raisonnement structuré, de règles internes, une forme de symbolisme diffus, non pas codé mais intégré dans l’architecture. Leur «Constitutional AI» évoque un LLM qui pense en suivant des principes : une piste encore hybride mais prometteuse.

Mistral

Du côté européen, Mistral s’est imposé comme un acteur minimaliste mais tranchant. Pas de robotique, pas de méta-structure, peu de discours sur l’AGI mais une efficacité redoutable dans la construction de modèles open-source puissants et sobres. Leur stratégie s’inscrit clairement dans le camp du scaling, avec une touche d’élégance algorithmique. Mistral joue la carte de la sobriété performative, en restant focalisé sur l’ingénierie brute, sans se disperser.

Tesla

De manière plus inattendue, Tesla est sans doute l’une des entreprises les plus radicalement corporealistes aujourd’hui. Son système de pilotage automatique ne repose pas sur des règles préétablies ou sur des cartes figées, mais sur un réseau neuronal embarqué, nourri par l’expérience de millions de kilomètres. Ici, la voiture devient un corps apprenant, un agent adaptatif. Avec le projet Optimus, un robot humanoïde, Tesla étend cette logique à la locomotion humaine. L’AGI, chez eux, est déjà incarnée, même si elle reste silencieuse pour l’instant.

IBM

IBM, quant à elle, reste fidèle à ses racines symboliques. Héritière des systèmes experts, elle continue à développer des outils hybrides pour la santé, le droit ou l’industrie. Chez IBM, l’intelligence est une affaire de logique, de causalité, de règles : pas de grand modèle multilingue qui devine, mais des architectures qui raisonnent, expliquent et justifient. Dans un monde obsédé par les effets émergents, IBM rappelle que la clarté reste une forme de puissance.

Les rebelles des architectures alternatives

(Les sentiers oubliés de la montagne AGI)

À l’écart des grandes voies, quelques grimpeurs solitaires avancent en silence. Leur conviction ? Le sommet de l’AGI ne se conquiert ni par la force brute, ni par l’avalanche de paramètres. Leur cri de guerre est simple : « L’intelligence humaine consomme 20 watts, pas une centrale nucléaire ! »

Des figures comme Yann LeCun ou Juergen Schmidhuber défendent une approche radicale : frugalité énergétique, apprentissage auto-supervisé, et architectures inspirées du cerveau. Pas de texte à gober, pas de milliards de poids, juste l’élégance d’un système qui apprend comme un enfant : en observant, en agissant, en simulant.

Plus bas, les neuromorphiques, avec SpiNNaker ou Loihi, rêvent de circuits qui pensent comme des neurones : sobres, efficaces, décentralisés. Leur but : libérer l’IA du cloud, et l’ancrer dans le silicium.

Pourquoi les écouter ? Parce qu’ils rappellent l’évidence : ajouter des paramètres n’est pas comprendre. Et si, à force de viser le sommet à coups de milliards, nous grimpions… la mauvaise montagne ?

Conclusion

Toutes ces informations me font réaliser à quel point l’intelligence humaine est évoluée et redoutablement efficace, ne serait-ce que par sa capacité à imaginer, à projeter, et à avancer chaque jour dans des territoires encore flous.

Je reste intimement persuadé que l’IA, et plus encore la quête de l’AGI, est en train de nous mener non pas vers une révolution purement technique, mais vers une révolution profondément humaine.

«L’intelligence, ce n’est pas seulement savoir, c’est aussi savoir ce qu’il faut faire du savoir.»

Isaac Asimov — Les Robots et l’Empire

AiBrain

AiBrain