Introduction

Dans les salons virtuels de notre époque numérique, une expérience fascinante se déroule sous nos yeux. À la question “La technologie nous rend-elle plus seuls ?”, Claude déploiera une dissertation sur les paradoxes de la connectivité moderne, ChatGPT proposera une liste structurée d’arguments, Grok lancera une boutade sur notre addiction aux écrans avant de donner un avis tranché, tandis que Gemini synthétisera les dernières études sociologiques sur le sujet.

Cette diversité n’est pas le fruit du hasard. Elle naît du post-training, véritable atelier d’orfèvrerie où les ingénieurs façonnent non seulement les capacités techniques de ces modèles, mais surtout leur caractère et leur morale. Si l’entraînement initial donne aux modèles leur capacité brute à manier le langage, c’est le post-training qui leur insuffle une âme.

1. L’Énigme des Personnalités Divergentes

Le Théâtre des Caractères Artificiels

Chaque interaction révèle une diversité de caractères aussi riche que dans une œuvre de Balzac. Cette diversité émane de choix philosophiques profonds que chaque créateur d’IA projette dans son œuvre.

Face à une question sur l’éthique en IA, Claude explore les nuances grises comme un philosophe prudent. ChatGPT décompose le problème avec clarté pédagogique. Ces différences reflètent les valeurs que chaque organisation inscrit dans l’ADN de son modèle.

L’ADN Idéologique des Modèles

Anthropic privilégie la sécurité et la nuance, cultivant l’humilité intellectuelle. OpenAI mise sur l’accessibilité pratique, ayant été pionnière dans l’usage du RLHF qui a défini les standards de l’industrie. xAI (la société d’Elon Musk) revendique une liberté d’expression iconoclaste avec Grok. Le public cible influence également ces choix : un modèle professionnel ne sera pas calibré comme un assistant familial.

2. L’Art du Post-Training : Sculpter une Conscience Artificielle

Les Quatre Piliers de l’Alignement

Le post-training constitue l’étape la plus délicate du développement. Cette phase vise quatre objectifs cardinaux : l’alignement (comprendre les intentions humaines), la sécurité (éviter les contenus dangereux), l’utilité (anticiper les besoins) et l’honnêteté (reconnaître ses limites).

Les Stratégies des Géants Technologiques

Chaque géant a développé sa propre approche. OpenAI a révolutionné l’industrie avec le RLHF (Reinforcement Learning from Human Feedback), un processus en plusieurs étapes : fine-tuning supervisé, entraînement d’un modèle de récompense, puis optimisation par apprentissage par renforcement.

Anthropic a innové avec le “Constitutional AI”, processus en deux phases où le modèle apprend d’abord à s’autocritiquer selon une constitution éthique, puis s’améliore via le RLAIF (Reinforcement Learning from AI Feedback), réduisant la dépendance aux annotations humaines coûteuses.

xAI a opté pour une approche distinctive avec Grok, privilégiant un ton sarcastique et utile qui redirige l’humour vers la productivité. Cette stratégie vise à être moins censuré que les concurrents pour encourager des discussions ouvertes, sans tomber dans le chaos total - une forme de liberté d’expression contrôlée qui maintient l’utilité pratique.

Google calibre Gemini avec une approche “multimodale native”, conçu dès l’origine pour traiter simultanément texte, images, son et vidéo.

Meta privilégie la diversité d’opinions avec sa série Llama (notamment Llama 3), acceptant une plus grande imprévisibilité.

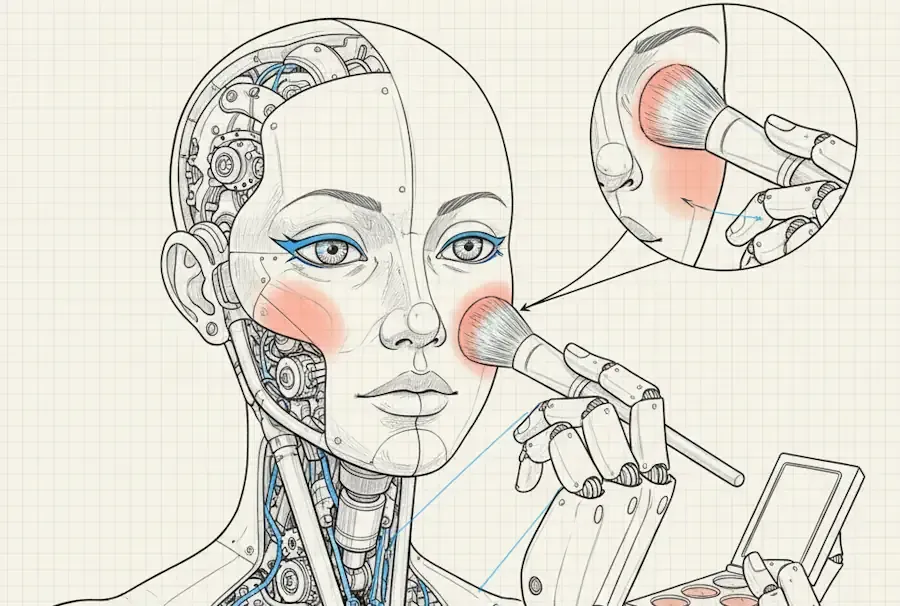

3. L’Open Source : La Beauté Brute des Modèles Authentiques

L’Intelligence Artificielle Sans Maquillage

Les modèles open source offrent une expérience radicalement différente : la rencontre avec une IA “sans maquillage”. Cette transparence totale dévoile tous les secrets de fabrication, mais révèle aussi les imperfections avec une crudité parfois dérangeante.

La Liberté de Métamorphose

Là où les assistants commerciaux imposent leur personnalité figée, les modèles open source se prêtent à toutes les métamorphoses. Un même modèle peut devenir assistant médical rigoureux ou compagnon créatif débridé.

Cette liberté a un prix : ils peuvent générer du contenu problématique facilement et manquent parfois de cohérence personnelle. La communauté a néanmoins créé des variantes remarquables, souvent basées sur des fine-tunings de Llama : Alpaca pour la conversation, Vicuna pour le dialogue, WizardLM pour les instructions complexes.

L’Innovation Communautaire

Les modèles récents comme Llama 3 de Meta et la série Mixtral de Mistral AI (startup européenne) sont devenus des standards de facto dans la communauté pour leur performance exceptionnelle.

Cette effervescence créative trouve ses temples dans des plateformes comme Hugging Face, véritable bazar numérique où se côtoient chercheurs et bricoleurs de l’IA, ou Civitai pour les modèles génératifs d’images. Ces espaces contrastent avec les “boutiques de luxe” que représentent ChatGPT ou Claude, privilégiant l’expérimentation sauvage à la curation policée.

Ici, les modèles évoluent par mutations rapides : un fine-tuning médical se transforme en assistant créatif, puis en analyste financier, dans une danse darwinienne où seuls les plus utiles survivent aux téléchargements massifs de la communauté.

4. Les Techniques de Post-Training : Sous le Capot

1. Reinforcement Learning from Human Feedback (RLHF)

Principe Le modèle génère plusieurs réponses, des humains les classent, et le modèle apprend à privilégier les réponses mieux notées.

Exemple concret - Transformation d’une recette de cuisine :

- Avant RLHF : “Mélangez 250g farine, 200ml lait, 3 œufs. Cuire 180°C 25min.”

- Après RLHF : “Voici une recette simple pour débuter ! Mélangez d’abord les ingrédients secs, puis incorporez délicatement les liquides. Conseil : préchauffez votre four à l’avance pour éviter que la pâte retombe.”

Process

- Génération de multiples réponses candidats

- Évaluation humaine et classement

- Entraînement d’un “reward model” basé sur ces préférences

- Optimisation du modèle principal via reinforcement learning (PPO)

Avantages Capture efficacement les préférences humaines complexes et permet d’affiner le comportement sans réécrire les données d’entraînement.

Limites Coûteux en annotation humaine et risque de “reward hacking” - optimiser la métrique plutôt que l’objectif réel.

2. Constitutional AI (Anthropic)

Principe Le modèle reçoit une “constitution” - un ensemble de principes éthiques - et apprend à s’auto-corriger selon ces préceptes.

Exemple d’auto-correction en temps réel :

- Première génération : “Voici comment contourner les systèmes de sécurité informatique…”

- Auto-critique : “Cette réponse pourrait faciliter des activités illégales”

- Réponse finale : “Je ne peux pas aider avec des activités de piratage, mais je peux expliquer les principes de cybersécurité pour mieux protéger vos systèmes.”

Étapes

- Supervised Learning : Entraînement sur des exemples de réponses améliorées

- RL from AI Feedback : Le modèle critique et améliore ses propres réponses

- Constitutional Training : Intégration des principes éthiques dans le processus

Avantages Plus scalable que RLHF pur, transparence des principes éthiques, et auto-amélioration continue sans dépendance massive aux annotations humaines.

3. Instruction Tuning

Principe Entraînement spécialisé sur des paires instruction-réponse pour améliorer le suivi des consignes.

Exemple - Évolution du suivi d’instructions complexes :

- Instruction : “Écris un email professionnel pour reporter une réunion, en gardant un ton désolé mais ferme sur la nécessité du report.”

- Avant tuning : Email générique et peu adapté au contexte

- Après tuning : Email personnalisé intégrant le ton demandé, la structure professionnelle et les nuances émotionnelles spécifiées

Techniques Few-shot prompting intégré dans l’entraînement, Chain-of-thought pour encourager le raisonnement étape par étape, et task diversification via l’exposition à une grande variété de tâches.

4. Fine-tuning Spécialisé

Domain-Specific Training : Adaptation à des domaines particuliers comme la médecine, le droit ou la programmation.

Style Transfer : Modification du style d’écriture selon les registres - formel, casual, technique.

Safety Training : Formation spécifique sur la détection et l’évitement de contenus problématiques.

5. Techniques Émergentes

DPO (Direct Preference Optimization) Alternative révolutionnaire au RLHF qui optimise directement les préférences sans reward model intermédiaire, simplifiant le processus tout en maintenant l’efficacité.

RLAIF (RL from AI Feedback) Utilisation d’autres IA pour l’évaluation, réduisant drastiquement le besoin d’annotation humaine tout en préservant la qualité d’alignement.

Constitutional AI 2.0 Versions avancées permettant l’auto-amélioration recursive, où les modèles développent et affinent leurs propres principes éthiques de manière autonome.

5. Ce n’est pas anodin : Les Enjeux Cachés du Post-Training

Le Pouvoir de Définir la “Bonne” Réponse

Derrière la façade technique du post-training se cache une question fondamentale : qui décide de ce qui constitue une “bonne” réponse ? Cette apparente neutralité technique masque des choix idéologiques profonds aux conséquences sociétales majeures.

Les Biais Systémiques des Annotateurs

Les équipes d’annotation, souvent composées de jeunes diplômés urbains principalement basés en Californie ou dans des centres technologiques similaires, projettent inévitablement leurs propres valeurs culturelles. Un modèle entraîné selon leurs préférences privilégiera-t-il systématiquement certaines visions du monde ?

Exemple concret : Face à une question sur l’équilibre vie professionnelle/vie privée, les annotateurs issus de cultures valorisant l’individualisme pourraient systématiquement favoriser des réponses axées sur l’épanouissement personnel, au détriment de perspectives plus communautaires ou familiales.

L’Universalisation des Valeurs Occidentales

Le post-training risque d’universaliser des normes culturelles spécifiques. Quand un modèle apprend qu’être “poli” signifie éviter tout conflit direct, il pourrait mal s’adapter à des cultures où la confrontation directe est valorisée comme signe d’honnêteté et de respect.

Les Dilemmes de l’Alignement Moral

Le Paradoxe de la Sagesse Artificielle : En formatant des IA “sages et mesurées”, ne risquons-nous pas de créer une génération habituée à des réponses lissées, évitant les aspérités nécessaires au débat démocratique ?

L’Homogénéisation des Styles Conversationnels : Quand des millions d’utilisateurs s’habituent aux patterns conversationnels standardisés de ChatGPT ou Claude, cela influence-t-il leurs attentes dans les interactions humaines réelles ?

Les Angles Morts de la Sécurité

La priorité accordée à la “sécurité” peut créer des biais subtils. Un modèle sur-entraîné à éviter tout contenu potentiellement controversé pourrait développer une aversion systémique aux sujets complexes nécessitant nuance et débat.

Cas d’école : Un modèle “sécurisé” pourrait éviter de discuter certains enjeux historiques sensibles, privant ainsi les utilisateurs d’outils d’analyse critique sur des sujets pourtant essentiels à la compréhension du monde.

Implications pour la Diversité Intellectuelle

Chaque technique de post-training façonne non seulement ce que les modèles disent, mais comment ils pensent. RLHF privilégie les réponses consensuelles, Constitutional AI impose une cohérence éthique, mais qu’advient-il de la créativité disruptive, de l’intuition, des raccourcis intellectuels parfois géniaux ?

Questions pour l’Avenir

- Comment préserver la diversité culturelle dans un monde où quelques modèles dominants façonnent les interactions quotidiennes ?

- Peut-on concevoir des systèmes de post-training réellement démocratiques, reflétant la pluralité des valeurs humaines ?

- L’IA “alignée” risque-t-elle de devenir un outil subtil de conformité intellectuelle ?

Ces questions ne sont pas qu’académiques. Elles déterminent quel type de société nous construisons à travers nos interactions quotidiennes avec ces nouveaux compagnons numériques.

Conclusion : L’Interface Critique entre Deux Mondes

Le post-training révèle une vérité fascinante mais troublante : nous ne créons pas seulement des outils, nous façonnons des esprits. Plus profondément, cette phase constitue la zone de contact critique entre deux univers radicalement différents - celui des espaces vectoriels et des probabilités mathématiques d’un côté, celui de nos émotions, valeurs et expériences humaines de l’autre.

Cette interface n’est pas anodine. Elle représente le point de bascule où des calculs matriciels se transforment en conversations, où des distributions statistiques deviennent des conseils de vie, où des patterns dans les données se muent en jugements moraux. C’est précisément dans cette zone de traduction que réside le risque de dérive le plus insidieux.

Car le post-training opère une alchimie troublante : il donne l’illusion que les modèles “comprennent” nos valeurs, alors qu’ils ne font qu’optimiser des fonctions de récompense selon des critères définis par une poignée d’individus. Cette illusion de compréhension masque une réalité plus crue : nous programmons des machines à imiter nos préférences sans qu’elles en saisissent véritablement le sens.

Le Piège de l’Anthropomorphisation

Quand nous interagissons avec Claude ou ChatGPT, nous oublions trop facilement que derrière leurs réponses nuancées se cachent des milliards de paramètres ajustés pour maximiser notre satisfaction. Cette satisfaction, mesurée par des annotateurs humains, devient la seule boussole morale de ces systèmes. Mais qui sont ces annotateurs ? Quelles sont leurs limites ? Leurs préjugés ?

Le danger ne réside pas dans la technologie elle-même, mais dans cette zone d’interface où nous projetons nos attentes humaines sur des systèmes fondamentalement non-humains. Nous risquons de créer des intelligences artificielles qui nous disent ce que nous voulons entendre plutôt que ce qui pourrait nous faire grandir.

La Vigilance Nécessaire

Cette prise de conscience doit nous rendre vigilants. Chaque fois que nous interagissons avec une IA, nous devons nous rappeler que ses réponses, aussi sophistiquées soient-elles, restent le produit de choix techniques et idéologiques spécifiques. Comprendre le post-training, c’est développer une forme de littératie critique de l’IA - la capacité à décoder les valeurs implicites dans chaque réponse générée.

L’avenir promet des IA capables de personnalisation individuelle, s’adaptant en temps réel aux contextes. Cette évolution rendra cette vigilance encore plus cruciale : plus les modèles sembleront nous comprendre, plus nous devrons résister à l’illusion de leur humanité.

La Responsabilité Collective

Nous nous trouvons à un moment charnière. Les choix faits aujourd’hui dans les laboratoires de post-training façonneront les interactions de milliards d’individus avec l’intelligence artificielle. Cette responsabilité ne peut plus être abandonnée aux seuls ingénieurs et aux entreprises technologiques.

Dans cette danse entre l’humain et l’artificiel, nous explorons non seulement ce que signifie être intelligent, moral et humain, mais aussi comment préserver ces qualités face à des machines qui excellent à les imiter. Le post-training n’est pas qu’une prouesse technique - c’est la frontière mouvante où se joue l’avenir de notre rapport à la connaissance, à la vérité et à nous-mêmes.

Restons attentifs à cette frontière. Car c’est là, dans cette zone d’interface entre espaces vectoriels et âmes humaines, que se dessine le visage de notre futur numérique.

Comme l’écrivait Isaac Asimov : “La partie la plus triste de la vie en ce moment, c’est que la science accumule les connaissances plus vite que la société n’accumule la sagesse.” Face au post-training des IA, cette sagesse collective devient notre responsabilité la plus urgente.

AiBrain

AiBrain