Simples ou complexes, adaptées à votre besoin.

Articles connexes : Guide de conception d’agents IA | Les 11 patterns d’orchestration multi-agents | Agent Skills : Le Manuel d’Onboarding

Introduction

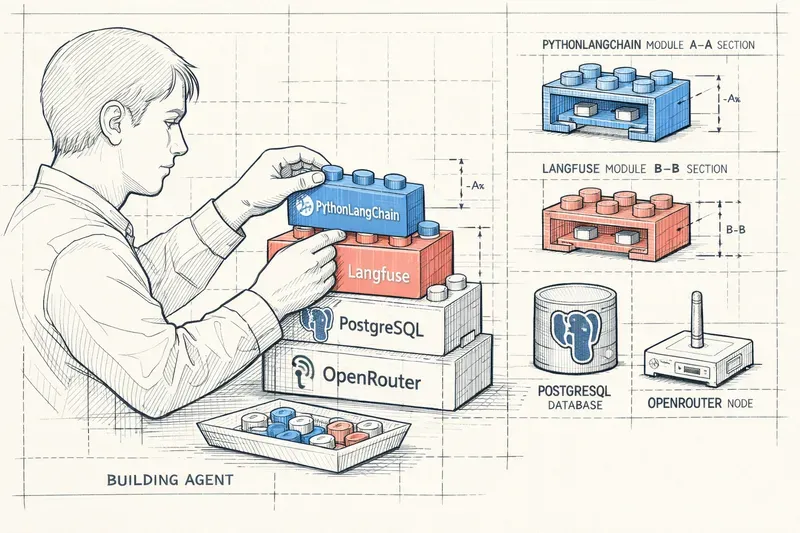

Développer un agent IA performant, c’est comme construire une maison : il ne suffit pas d’empiler des matériaux au hasard. Chaque composant a son rôle, ses forces, ses limites. Après plus de 20 ans de développement logiciel et beaucoup d’expérimentation avec l’IA, j’ai appris qu’un agent robuste repose sur six piliers fondamentaux : les langages et APIs qui le font fonctionner, l’orchestration qui coordonne ses actions, les modèles qui lui donnent son intelligence, la télémétrie qui permet de comprendre son comportement, le storage qui préserve sa mémoire, et le runtime qui détermine où et comment il s’exécute.

Cet article vous guide à travers ces six domaines, en présentant les outils disponibles. Ps: Liste non exhaustive

Langages & API : Les Fondations du Code

Le choix du langage et des frameworks API détermine la vélocité de développement, la maintenabilité et les performances de votre agent. Voici ma boîte à outils.

Python

Description : Python est le langage de référence pour l’IA, avec l’écosystème le plus riche en bibliothèques de machine learning et de traitement de données.

Avantages :

- Écosystème ML inégalé (PyTorch, TensorFlow, scikit-learn, Hugging Face)

- Syntaxe claire et expressive, idéale pour le prototypage rapide

- Communauté massive et documentation exhaustive

- Intégration native avec Jupyter pour l’expérimentation

- Excellente gestion des notebooks pour la recherche

TypeScript

Description : TypeScript est mon langage de prédilection pour les agents en production. JavaScript avec typage statique, offrant robustesse et excellente expérience développeur.

www.typescriptlang.orgAvantages :

- Typage statique qui élimine une classe entière de bugs

- Écosystème npm gigantesque pour toute intégration

- Performances excellentes avec Node.js pour les API

- Support async/await et parallelisation natif, parfait pour les agents

- Code partagé entre frontend et backend

- Outillage de développement exceptionnel (VSCode, ESLint, Prettier)

FastAPI

Description : FastAPI est un framework Python moderne pour créer des APIs RESTful ultra-rapides avec validation automatique et documentation interactive.

fastapi.tiangolo.comAvantages :

- Performances proches de Node.js grâce à Starlette et Pydantic

- Validation automatique des données via type hints Python

- Documentation OpenAPI générée automatiquement (Swagger UI)

- Support async/await natif pour haute concurrence

- Typage fort avec excellente expérience développeur

- Déploiement simple et scalabilité horizontale aisée

Fastify

Description : Fastify est un framework web Node.js ultra-performant, orienté sur la vitesse et les faibles coûts de ressources.

www.fastify.ioAvantages :

- Le framework Node.js le plus rapide (benchmarks constants)

- Architecture basée sur des plugins modulaires

- Validation de schéma JSON intégrée (Ajv)

- Faible empreinte mémoire

- Logging structuré intégré

- TypeScript first-class citizen

Webhooks

Description : Architecture événementielle pour communiquer entre systèmes de manière asynchrone et découplée.

fr.wikipedia.org/wiki/WebhookAvantages :

- Communication asynchrone sans polling constant

- Découplage fort entre systèmes

- Scalabilité naturelle (push vs pull)

- Standard de facto pour les intégrations SaaS

- Facilite l’architecture event-driven

- Debugging simplifié avec outils comme ngrok ou webhook.site

MCP (Model Context Protocol) / Tools

Description : MCP (Model Context Protocol) est un protocole émergent pour standardiser l’interaction entre modèles LLM et outils externes, développé par Anthropic.

modelcontextprotocol.ioAvantages :

- Standard ouvert pour l’intégration d’outils avec les LLMs

- Découplage entre logique métier et invocation de modèles

- Gestion du contexte et de la mémoire standardisée

- Facilite la création d’agents modulaires

- Interopérabilité entre différents modèles et providers

2. Orchestration : Le Chef d’Orchestre de Vos Agents

L’orchestration détermine comment vos agents coordonnent leurs actions, gèrent les workflows complexes et maintiennent la cohérence. C’est le cerveau de votre système multi-agents.

N8N

Description : N8N est une plateforme d’automatisation no-code/low-code pour créer des workflows visuels connectant des centaines de services.

n8n.ioAvantages :

- Interface visuelle intuitive pour construire des workflows

- 400+ intégrations natives (APIs, bases de données, services cloud)

- Self-hosted : contrôle total de vos données

- Logique conditionnelle et boucles pour workflows complexes

- Exécution JavaScript custom pour flexibilité maximale

- Webhooks entrants/sortants natifs

- Gestion des erreurs et retry automatique

LangChain

Description : LangChain est un framework Python/TypeScript pour développer des applications pilotées par des LLMs avec des chaînes de prompts et des agents.

www.langchain.comAvantages :

- Abstractions puissantes pour les chaînes de prompts

- Intégration de dizaines de LLMs (OpenAI, Anthropic, Cohere, etc.)

- Bibliothèque d’outils et de loaders (documents, web, APIs)

- Support de la mémoire conversationnelle

- Agents autonomes avec ReAct et autres patterns

- Large communauté et exemples nombreux

LangGraph

Description : LangGraph est une extension de LangChain pour créer des agents avec des workflows sous forme de graphes orientés, offrant un contrôle fin sur les flux d’exécution.

langchain-ai.github.io/langgraphAvantages :

- Modélisation visuelle des workflows agents sous forme de graphes

- Gestion d’états complexes entre nœuds

- Boucles, conditionnelles et branches multiples

- Débogage facilité grâce à la structure explicite

- Persistance et reprise de workflows

- Parfait pour les systèmes multi-agents coordonnés

CrewAI

Description : CrewAI est un framework Python pour créer des équipes d’agents IA collaboratifs avec rôles, objectifs et processus définis.

www.crewai.comAvantages :

- Paradigme “équipe” : chaque agent a un rôle spécifique

- Orchestration automatique de la collaboration entre agents

- Délégation de tâches et hiérarchie agents

- Processus séquentiel ou parallèle configurable

- Mémoire partagée entre agents

- Intégration native avec LangChain

Pydantic AI

Description : Pydantic AI est un framework léger qui utilise Pydantic pour la validation de données et la structuration des sorties LLM.

ai.pydantic.devAvantages :

- Validation stricte des entrées/sorties via schémas Pydantic

- Typage fort pour réduire les erreurs d’agents

- Conversion automatique JSON ↔ objets Python

- Intégration naturelle avec FastAPI

- Génération de prompts structurés

- Léger et sans dépendances lourdes

Sur Mesure (Custom Orchestration)

Description : Développement d’un système d’orchestration personnalisé, adapté exactement à vos besoins spécifiques. C’est l’approche de mon framework Poulpikan.

Avantages :

- Contrôle total sur la logique d’orchestration

- Zéro abstraction inutile : performance optimale

- Architecture adaptée à votre domaine métier

- Pas de dépendance à un framework tiers

- Évolution libre selon vos besoins

- Courbe d’apprentissage pour votre équipe minimale

- Debugging et observabilité sur-mesure

3. Models : L’Intelligence de Vos Agents

Le modèle que vous choisissez détermine les capacités cognitives de votre agent. Chaque modèle a ses forces : certains excellent en raisonnement, d’autres en rapidité ou en compréhension visuelle.

LLM (Large Language Models)

Description : Modèles de langage génératifs capables de comprendre et générer du texte humain. La fondation de tout agent conversationnel.

Avantages :

- Compréhension contextuelle profonde du langage naturel

- Génération de texte cohérent et créatif

- Raisonnement et résolution de problèmes

- Few-shot learning : apprend de quelques exemples

- Multilingue sans entraînement spécifique

Vision

Description : Modèles capables d’analyser et comprendre des images, de les décrire ou d’en extraire de l’information structurée.

Avantages :

- Analyse d’images sans entraînement spécifique

- Détection d’objets, de texte (OCR), de scènes

- Génération de descriptions détaillées

- Classification d’images

- Extraction de données de documents visuels (factures, diagrammes)

Embedding

Description : Modèles qui transforment du texte en vecteurs numériques capturant le sens sémantique, essentiels pour la recherche et la comparaison de similarité.

Avantages :

- Recherche sémantique (au-delà des mots-clés)

- Clustering et classification de documents

- Détection de similarité et de duplicatas

- Base de la RAG (Retrieval-Augmented Generation)

- Performances élevées pour faible coût

- Déterministe : même texte = même embedding

Image Generation

Description : Modèles génératifs capables de créer des images à partir de descriptions textuelles (text-to-image).

Avantages :

- Création de visuels sans designer

- Itération rapide sur des concepts visuels

- Styles artistiques variés

- Génération de variations à partir d’images existantes

- Intégration dans des workflows créatifs

Audio

Description : Modèles pour la transcription (speech-to-text), la synthèse vocale (text-to-speech), et l’analyse audio.

Avantages :

- Transcription multilingue précise

- Synthèse vocale naturelle et expressive

- Traduction audio automatique

- Sous-titrage automatique

- Interfaces vocales pour agents

Reranker

Description : Modèles spécialisés pour réordonner des résultats de recherche selon leur pertinence réelle pour une requête, améliorant drastiquement la qualité des systèmes RAG.

Avantages :

- Précision supérieure aux embeddings seuls

- Améliore significativement les résultats RAG

- Comprend les nuances sémantiques fines

- Élimine les résultats non pertinents mais lexicalement proches

- Coût faible en post-traitement

4. Telemetry : Observer pour Comprendre et Améliorer

Sans télémétrie, votre agent est une boîte noire. Mesurer, tracer et analyser sont essentiels pour déboguer, optimiser et monitorer en production.

LangSmith

Description : LangSmith est une plateforme de développement et monitoring pour applications LLM, par les créateurs de LangChain.

www.langchain.com/langsmithAvantages :

- Traçage complet des chaînes LangChain

- Visualisation des prompts et réponses à chaque étape

- Calcul automatique des coûts (tokens, appels API)

- Debugging facilité avec replay de sessions

- Datasets de test et évaluation automatisée

- Monitoring production et alertes

- Annotations humaines pour amélioration continue

Langfuse

Description : Langfuse est une alternative open-source à LangSmith, offrant observabilité et analytics pour applications LLM, avec option self-hosted.

langfuse.comAvantages :

- Open-source : contrôle total et pas de vendor lock-in

- Self-hosted possible : données sensibles restent chez vous

- Traçage de sessions multi-tours

- Métriques de performance et coûts détaillés

- Intégration avec LangChain, LlamaIndex et APIs directes

- Dashboard de monitoring en temps réel

- Export de données pour analyses custom

Phoenix

Description : Phoenix est une plateforme open-source d’observabilité ML spécialisée dans le tracing et l’évaluation de systèmes LLM et embeddings.

arize.com/phoenixAvantages :

- Visualisation des embeddings et drift detection

- Analyse de la qualité des retrievals (RAG)

- Détection d’hallucinations et de toxicité

- Interface notebook-friendly (Jupyter)

- Léger et rapide à déployer

- Focus sur l’évaluation qualitative

5. Storage : La Mémoire de Vos Agents

Un agent sans mémoire ne peut ni apprendre ni maintenir du contexte entre les sessions. Le choix du storage impacte performances, scalabilité et capacités de votre agent.

PostgreSQL

Description : PostgreSQL est une base de données relationnelle open-source robuste, éprouvée, avec extension pgvector pour le stockage de vecteurs.

www.postgresql.orgAvantages :

- Fiabilité et maturité inégalées (30+ ans)

- ACID complet : consistance garantie

- pgvector : stockage et recherche d’embeddings native

- Performances excellentes avec indexation appropriée

- Écosystème tooling riche (backups, monitoring, migrations)

- Support JSON pour flexibilité

- Self-hosted ou managed (AWS RDS, Supabase, etc.)

pgvector

Description : pgvector est une extension PostgreSQL permettant de stocker et rechercher efficacement des vecteurs d’embeddings directement dans Postgres.

github.com/pgvector/pgvectorAvantages :

- Tout dans une seule base : vecteurs + métadonnées

- Recherche de similarité rapide (HNSW, IVFFlat)

- Filtrage combiné : sémantique + attributs classiques

- Pas besoin de base vectorielle séparée

- Transactions ACID même pour les vecteurs

- Coût infrastructure réduit

ChromaDB

Description : ChromaDB est une base de données vectorielle open-source légère, conçue spécifiquement pour les embeddings et la rechersearch chroma.com

www.trychroma.comAvantages :

- Setup ultra-simple :

pip install chromadb - Mode embedded : pas de serveur séparé nécessaire

- API Python intuitive

- Métadonnées riches sur chaque vecteur

- Filtrage sémantique + métadonnées combiné

- Léger en ressources

- Parfait pour prototypage et expérimentation

Pinecone

Description : Pinecone est une base de données vectorielle managed, optimisée pour la recherche de similarité à très large échelle.

www.pinecone.ioAvantages :

- Managed : zéro ops, scalabilité automatique

- Performances excellentes à très grande échelle (milliards de vecteurs)

- Latence faible (<100ms) même sur gros volumes

- Filtrage par métadonnées sophistiqué

- Namespaces pour isolation de données

- APIs simples et SDKs multiples

- Monitoring et analytics intégrés

Supabase

Description : Supabase est une alternative open-source à Firebase, basée sur PostgreSQL, offrant base de données, auth, storage et APIs générées automatiquement.

supabase.comAvantages :

- PostgreSQL + pgvector : puissance relationnelle + vecteurs

- Authentication et autorisation intégrées

- APIs REST et GraphQL auto-générées

- Storage de fichiers S3-compatible

- Realtime subscriptions (WebSocket)

- Dashboard admin complet

- Self-hosted ou managed

- Gratuit jusqu’à des volumes conséquents

SQLite

Description : SQLite est une base de données SQL embarquée, légère, sans serveur, stockée dans un simple fichier.

www.sqlite.orgAvantages :

- Ultra-léger : une seule bibliothèque, un fichier

- Zéro configuration : pas de serveur à gérer

- Performances excellentes en lecture

- Transactions ACID complètes

- Portable : copiez le fichier = migrez la base

- Parfait pour edge computing et applications locales

- Support vectoriel via extensions (sqlite-vss)

6. Runtime & Hosting : Où Bat le Cœur de l’Agent ?

Le choix de l’infrastructure d’inférence est le compromis ultime entre latence, coût et souveraineté. C’est souvent le point négligé lors de la conception, mais il détermine l’expérience utilisateur finale et votre facture mensuelle.

OpenRouter

OpenRouter

Description : OpenRouter est une API unifiée donnant accès à presque tous les modèles du marché (OpenAI, Anthropic, mais aussi Groq, Together, et des dizaines d’autres).

openrouter.aiAvantages :

- Une seule API pour 150+ modèles

- Un seul compte, un seul billing

- Switch de modèle en changeant un paramètre

- Failover automatique entre providers

- Comparaison de prix en temps réel

- Parfait pour l’expérimentation multi-modèles

- Évite le vendor lock-in total

Local + Hébergement Open-Source {#local-hebergement-opensource}

Pour ceux qui veulent garder le contrôle total de leur infrastructure et de leurs données, ces solutions permettent d’héberger vos propres modèles open-source.

Together AI {#together-ai}

Description : Together AI est une plateforme d’inférence cloud spécialisée dans les modèles open-source, avec un excellent rapport performance/prix.

www.together.aiAvantages :

- Large catalogue de modèles open-source (Llama 3, Qwen, Mistral, etc.)

- Infrastructure optimisée pour la production

- Scaling automatique et fiabilité élevée

- Prix attractifs, souvent 2-5x moins cher que OpenAI

- Fine-tuning facilité sur leurs clusters

- Support de modèles de niche (code, multimodal, etc.)

Fireworks AI {#fireworks-ai}

Description : Fireworks AI est une plateforme d’inférence rapide et économique pour modèles open-source, avec focus sur la vitesse et le fine-tuning.

fireworks.aiAvantages :

- Performances excellentes (200-400 tokens/s)

- Fine-tuning simple et rapide

- API compatible OpenAI : migration facile

- Prix très compétitifs

- Latence faible et uptime élevé

- Bonne documentation et SDKs

DeepInfra

Description : DeepInfra est un service d’inférence économique pour modèles open-source, optimisé pour les gros volumes.

deepinfra.comAvantages :

- Tarification ultra-agressive : parfait pour gros volumes

- Large choix de modèles open-source

- Pay-as-you-go sans engagement

- Scaling automatique

- Bon pour l’expérimentation à moindre coût .

Groq

Groq

Description : Groq est une infrastructure d’inférence ultra-rapide basée sur des LPUs (Language Processing Units), optimisée spécifiquement pour les transformers.

groq.comAvantages :

- Latence inégalée : 500-1000 tokens/seconde

- Time-to-first-token quasi-instantané (<50ms)

- Parfait pour les interactions vocales temps-réel

- Support des modèles Llama, Mixtral, Gemma

- Tarification compétitive malgré les performances

- Expérience utilisateur “magique” : zéro temps d’attente perceptible

Les Entreprises Française

Pour les projets nécessitant conformité RGPD, souveraineté des données et support français, ces acteurs français offrent des solutions robustes.

Scaleway (Generative APIs)

Description : Scaleway Generative APIs est une offre française robuste pour déployer des modèles open-source sur une infrastructure souveraine avec tarification transparente.

www.scaleway.com/fr/aiAvantages :

- Données hébergées en France (Paris, Amsterdam)

- Conformité RGPD native

- Modèles Llama, Mistral, et autres open-source

- Tarification claire et prédictible

- Support en français

- Intégration avec l’écosystème Scaleway (compute, storage, etc.)

- Excellent pour les marchés publics et secteurs régulés

OVHcloud (AI Endpoints)

Description : OVHcloud AI Endpoints est un service d’inférence du leader européen du cloud, idéal pour les infrastructures déjà sur OVH.

www.ovhcloud.com/fr/public-cloud/ai-machine-learningAvantages :

- Hébergement 100% européen (France, Allemagne, UK)

- Intégration profonde avec services OVH existants

- Prix compétitifs avec engagement tarifaire

- Modèles open-source variés

- Support technique de qualité

- Certification ISO27001, HDS pour santé

Mistral AI (La Plateforme) {#mistral-ai}

Description : Mistral AI offre un accès direct aux modèles de la pépite française de l’IA, avec options d’hébergement européen.

mistral.aiAvantages :

- Modèles Mistral Large, Medium, Small : excellents performances

- Fenêtres de contexte larges (32k-128k tokens)

- Option hébergement sur sol européen

- Prix compétitifs vs OpenAI

- Support du français de qualité

- Roadmap produit dynamique

Les Big (Hyperscalers)

Le choix de la sécurité “Enterprise”, de l’intégration profonde et des garanties SLA pro pour les grandes organisations.

AWS Bedrock {#aws-bedrock}

Description : AWS Bedrock est un service d’inférence managé d’Amazon, avec focus sur la sécurité et l’isolation des données.

aws.amazon.com/bedrockAvantages :

- Données ne quittent jamais votre VPC AWS

- Sécurité et conformité enterprise (SOC2, HIPAA, etc.)

- Accès à Claude (Anthropic), Llama, Titan, Jurassic

- Intégration native avec services AWS (Lambda, S3, etc.)

- Pas de partage de données avec les providers de modèles

- Guardrails et filtrage de contenu intégrés

- Support enterprise AWS

Google Vertex AI {#vertex-ai}

Description : Google Vertex AI est une plateforme ML/AI complète de Google, donnant accès à la famille Gemini et à des outils ML avancés.

cloud.google.com/vertex-aiAvantages :

- Accès exclusif à Gemini (1M+ tokens de contexte)

- Fenêtres de contexte gigantesques : parfait pour analyser des documents entiers

- Intégration profonde avec GCP (BigQuery, Cloud Storage, etc.)

- Outils MLOps complets (training, tuning, deployment)

- Multimodalité native (texte, image, vidéo, audio)

- Pricing transparent avec engagement possible

Azure OpenAI {#azure-openai}

Description : Azure OpenAI est un service OpenAI hébergé sur Azure, avec garanties enterprise Microsoft.

azure.microsoft.com/fr-fr/products/ai-services/openai-serviceAvantages :

- GPT-4, GPT-4o avec SLA enterprise

- Intégration native avec Microsoft 365, Teams, etc.

- Données isolées dans votre tenant Azure

- Conformité enterprise (ISO, SOC2, HIPAA)

- Support Microsoft de niveau enterprise

- Parfait pour organisations Microsoft-centric

- Fine-tuning sur vos données privées

Cloudflare Workers AI {#cloudflare-workers-ai}

Description : Cloudflare Workers AI est un service d’inférence sur l’edge de Cloudflare, exécutant des modèles au plus proche des utilisateurs.

developers.cloudflare.com/workers-aiAvantages :

- Exécution sur le “Edge” (réseau CDN Cloudflare)

- Latence réseau minimale : 50-95% d’utilisateurs <50ms

- Small Language Models optimisés pour l’edge

- Tarification serverless attractive

- Pas de cold start

- Intégration avec Workers (serverless functions)

- Global par défaut : déployé sur 300+ data centers

Conclusion : Choisir, Assembler, Itérer

Construire un agent, ce n’est pas choisir les technologies les plus hype, c’est assembler les bonnes briques pour résoudre votre problème spécifique. Chaque projet a ses contraintes : budget, scalabilité attendue, compétences de l’équipe, criticité des données, vitesse de développement requise.

Et surtout, n’ayez pas peur d’écrire du code sur-mesure. Les frameworks sont des outils, pas des dogmes. Parfois, 200 lignes de TypeScript bien pensées battent 2000 lignes d’abstractions mal comprises.

Chez HeyIntent, c’est cette philosophie qui guide mes projets : comprendre le besoin métier, choisir les briques adaptées, construire robuste, mesurer, itérer. Pas de magie, juste de l’ingénierie.

Besoin d’un agent sur-mesure pour votre projet ? Je suis disponible pour des collaborations techniques. Contactez-moi pour en discuter.

Pour aller plus loin

- Guide de Conception d’Agents IA : Ce qui Fonctionne, Ce qui Échoue — La règle d’or du feedback déterministe et les 7 principes de design

- Méta-analyse : Capacités, Limitations et Patterns des Agents IA — Analyse systématique de 100+ publications avec verdicts par pattern

- Les 11 Patterns d’Orchestration Multi-Agents — Pipeline, Supervisor, Council, Swarm : quel pattern choisir ?

- Agent Skills : Le Manuel d’Onboarding — Structurer les instructions pour des agents spécialisés

AiBrain

AiBrain