Articles connexes : Recette LLM façon GPT : l’architecture expliquée | Comment l’attention multi-head permet aux LLM de comprendre

Résumé exécutif

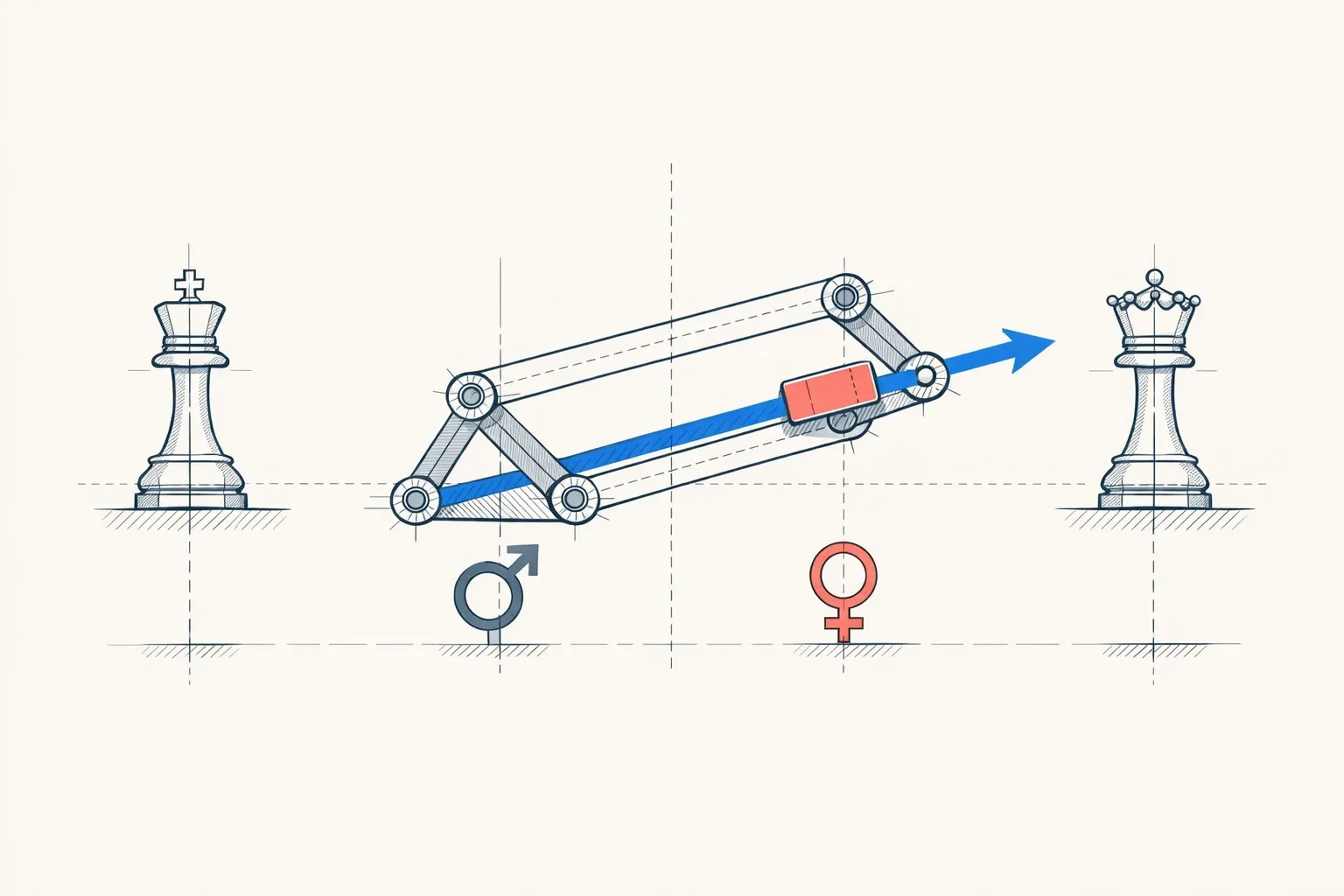

Cet article démystifie l’analogie célèbre “roi - homme + femme = reine” en expliquant comment les modèles d’IA, via les embeddings, représentent les mots comme des points dans un espace vectoriel multidimensionnel. Les traits sémantiques (royauté, genre, etc.) forment des axes, permettant des opérations arithmétiques qui capturent des relations linguistiques.

Points clés :

- Mots → vecteurs numériques (embeddings statiques comme Word2Vec, contextuels dans Transformers).

- Arithmétique vectorielle : soustraire/ajouter modifie les traits (ex. changer genre).

- Apprentissage automatique à partir de contextes textuels.

- Limites : simplifications pédagogiques, biais potentiels.

Idéal pour comprendre les bases de la sémantique computationnelle sans maths avancées.

Glossaire : Comprendre les termes techniques

- Embedding

- Représentation d’un mot (ou phrase) sous forme de vecteur numérique multidimensionnel capturant ses traits sémantiques. Les vecteurs proches correspondent à des sens similaires.

- Word2Vec* : Algorithme d’apprentissage pour générer des embeddings statiques en analysant les contextes des mots dans de grands corpus textuels.

- Transformer

- Architecture de réseau neuronal (base de GPT, BERT) utilisant un mécanisme d’attention pour produire des embeddings contextuels, adaptatifs au contexte de la phrase.

- Vecteur sémantique

- Liste de nombres (ex. [0.9, -0.2, 0.7]) définissant la position d’un mot dans l’espace des significations.

- Analogie vectorielle

- Opération comme roi - homme + femme qui navigue dans l’espace sémantique pour trouver un mot analogue (reine).

- Mécanisme d’attention

- Composant des transformers qui pondère l’importance des mots voisins pour ajuster dynamiquement les embeddings.

Vous avez peut-être déjà vu cette équation étrange : “roi - homme + femme = reine”. Comment peut-on soustraire un mot d’un autre ? Comment l’intelligence artificielle peut-elle résoudre des problèmes de maths… avec du vocabulaire ? C’est comme si les mots avaient une existence mathématique cachée. Et c’est exactement le cas.

Les Mots Comme Points sur une Carte

Imaginez que vous devez placer tous les mots du français sur une carte géante. Pas n’importe comment : les mots similaires doivent être proches. “Chat” près de “chien”, “roi” près de “reine”, “Paris” près de “France”.

Pour y arriver, vous décidez d’utiliser des axes de caractéristiques. Comme sur une carte géographique avec latitude et longitude, chaque mot aura des coordonnées. Mais au lieu de “nord-sud” et “est-ouest”, vos axes représentent des traits de sens :

- Un axe “royauté” (de “mendiant” à “empereur”)

- Un axe “genre” (de “masculin” à “féminin”)

- Un axe “âge” (de “bébé” à “centenaire”)

- Et des centaines d’autres…

Le mot “roi” aurait des coordonnées comme :

- Royauté : 9/10 (très royal)

- Genre : 2/10 (masculin)

- Âge : 7/10 (plutôt âgé)

Le mot “reine” serait presque au même endroit, mais avec un changement :

- Royauté : 9/10 (toujours très royal)

- Genre : 8/10 (féminin)

- Âge : 7/10 (même âge approximatif)

C’est ce qu’on appelle un embedding : transformer un mot en liste de nombres qui capturent son sens.

Le Problème Que Ça Résout

Pendant des décennies, les ordinateurs traitaient les mots comme des étiquettes sans lien. “Roi” et “reine” n’avaient rien en commun pour une machine. “Chat” et “chien” non plus.

Pour qu’une IA comprenne le langage, elle doit saisir que :

- “Roi” et “monarque” sont proches

- “Roi” et “reine” partagent la royauté mais diffèrent par le genre

- “Roi” et “carotte” n’ont rien à voir

Les embeddings résolvent ce problème en donnant une géométrie au langage. Les mots similaires deviennent des points proches dans un espace mathématique. Et cette proximité permet des calculs.

L’Arithmétique des Mots Expliquée

Revenons à notre équation : roi - homme + femme = reine.

Imaginons trois axes simplifiés :

- Axe royauté (horizontal)

- Axe genre (vertical)

- Axe âge (profondeur, qu’on va ignorer pour simplifier)

| Étape | Mot | Royauté | Genre | Notes |

|---|---|---|---|---|

| 1 | roi | 9/10 | 2/10 | Masculin / Position : en haut à droite |

| 2a | homme (à soustraire) | 5/10 | 2/10 | Neutre (peut être n’importe qui) / Masculin |

| 2b | Après soustraction | 4 | 0 | 9-5 / 2-2 (neutre maintenant) |

| 3a | femme (à ajouter) | 5/10 | 8/10 | Neutre / Féminin |

| 3b | Résultat final | 9 | 8 | 4+5 / 0+8 |

On a enlevé le trait “masculin” et une partie de la normalité sociale, puis ajouté le trait “féminin”.

C’est exactement les coordonnées de reine !

Pourquoi Ça Marche : Les Directions Ont du Sens

La magie, c’est que les différences entre mots capturent des relations pures.

“Homme” - “femme” crée un vecteur (une flèche) qui représente le changement de genre masculin vers féminin. Cette flèche a la même direction et longueur que “roi” - “reine”, ou “oncle” - “tante”, ou “acteur” - “actrice”.

C’est comme si le langage avait des directions universelles :

- La direction “masculin → féminin”

- La direction “singulier → pluriel”

- La direction “présent → passé”

En naviguant selon ces directions, on peut explorer les relations entre mots mathématiquement.

L’Exemple Fil Rouge : Paris et Capitales

Prenons un autre cas : “Paris - France + Italie = ?”

| Étape | Mot | Capitale | Francité | Taille | Notes |

|---|---|---|---|---|---|

| 1 | Paris | 10/10 | 9/10 | 8/10 | Point de départ |

| 2a | France (à soustraire) | 5/10 | 10/10 | 9/10 | Pays, pas ville / Grand pays |

| 2b | Après soustraction | 5 | -1 | -1 | 10-5 / 9-10 / 8-9 |

| 3a | Italie (à ajouter) | 5/10 | 1/10 | 8/10 | Pas français |

| 3b | Résultat final | 10 | 0 | 7 | 5+5 / -1+1 / -1+8 |

On a extrait “l’essence de capitale” en retirant le contexte français, puis ajouté le contexte italien.

Le mot le plus proche de ces coordonnées ? Rome.

Comment l’IA Apprend Ces Coordonnées

Vous vous demandez peut-être : qui décide que “roi” vaut 9/10 en royauté ? Personne.

L’IA apprend ces coordonnées automatiquement en lisant des milliards de phrases. Elle utilise un principe simple : les mots qui apparaissent dans des contextes similaires ont des sens similaires.

Si l’IA lit :

- “Le roi porte une couronne”

- “La reine porte une couronne”

- “Le monarque porte une couronne”

Elle en déduit que “roi”, “reine” et “monarque” doivent être proches dans l’espace des coordonnées, car ils partagent les mêmes voisins (“porte”, “couronne”).

Les algorithmes comme word2vec ajustent les coordonnées de millions de mots pour que cette règle soit respectée partout. Après des jours de calcul, les mots ont trouvé leur place naturelle sur la carte.

La Différence avec les Transformers Modernes

Jusqu’ici, on a parlé d’embeddings statiques : “roi” a toujours les mêmes coordonnées.

Mais les systèmes modernes comme ChatGPT utilisent des transformers, où les coordonnées changent selon le contexte.

Prenez le mot “banque” :

- “J’ai déposé de l’argent à la banque” → coordonnées proches de “finance”

- “Je me suis assis sur la banque de la rivière” → coordonnées proches de “rive”

Dans un transformer, “banque” n’a pas une position fixe. Ses coordonnées sont recalculées pour chaque phrase, en fonction des mots voisins. Le mécanisme d’attention (un autre sujet fascinant) permet ces ajustements dynamiques.

L’arithmétique “roi - homme + femme” fonctionne toujours, mais elle devient plus subtile : les coordonnées de “roi” dépendent maintenant de la phrase où il apparaît.

Récapitulatif du Parcours

Vous venez de comprendre comment l’IA transforme les mots en mathématiques :

- Chaque mot devient un point dans un espace à centaines de dimensions

- Chaque dimension capture un trait de sens (royauté, genre, etc.)

- Les mots similaires sont des points proches

- Soustraire ou ajouter des mots modifie ces coordonnées

- Les relations entre mots deviennent des directions géométriques

“Roi - homme + femme = reine” n’est pas de la magie : c’est de la navigation dans l’espace du sens.

Simplifications Pédagogiques

Pour rendre ce concept accessible, j’ai fait plusieurs simplifications volontaires :

Ce qui a été simplifié :

-

Le nombre de dimensions : J’ai parlé de 3-4 axes (royauté, genre, âge) alors que les vrais embeddings en ont 300 à 1000. Impossible de visualiser 768 dimensions, donc on réduit à ce que notre cerveau peut imaginer.

-

L’interprétabilité des dimensions : J’ai nommé les axes (“royauté”, “genre”). En réalité, les dimensions sont apprises automatiquement et n’ont pas de nom clair. La dimension 247 ne signifie pas “royauté” de façon évidente. Certaines dimensions capturent des combinaisons floues de plusieurs traits.

-

La précision des calculs : J’ai utilisé des scores sur 10 pour simplifier. Les vrais embeddings sont des nombres décimaux entre -1 et 1 (ou autres échelles), avec une précision extrême.

-

La complexité de word2vec : J’ai dit “l’IA lit des phrases et apprend”. En réalité, word2vec utilise des réseaux de neurones qui prédisent les mots voisins, avec des fonctions mathématiques complexes (softmax, descente de gradient).

-

Les transformers : J’ai mentionné que les embeddings deviennent contextuels, mais je n’ai pas expliqué le mécanisme d’attention qui permet ça. C’est un autre article entier.

Pourquoi ces simplifications sont OK :

- L’intuition reste exacte : Les mots sont vraiment des points dans un espace multidimensionnel, et l’arithmétique fonctionne vraiment.

- Les principes sont vrais : Les dimensions capturent des traits sémantiques, même si c’est moins net que “royauté” ou “genre”.

- La progression est respectée : Comprendre les embeddings statiques est un prérequis pour comprendre les transformers.

Ce qui reste rigoureusement exact :

- Les embeddings transforment les mots en vecteurs numériques

- Les mots similaires ont des vecteurs proches (distance euclidienne)

- L’arithmétique vectorielle capture des relations sémantiques

- “Roi - homme + femme” donne vraiment un vecteur proche de “reine” dans word2vec

- Les transformers rendent ces embeddings contextuels

Si vous retenez que les mots ont une géométrie et que les relations entre mots sont des directions, vous avez compris l’essentiel. Le reste, ce sont des détails techniques pour raffiner cette intuition.

Pour Aller Plus Loin

Maintenant que vous avez saisi le principe, des questions s’ouvrent :

-

Toutes les analogies marchent-elles ? Non. “Roi - homme + femme” est un exemple célèbre parce qu’il marche bien, mais beaucoup d’analogies échouent. Pourquoi certaines relations sont-elles capturées et d’autres non ?

-

Comment visualiser 768 dimensions ? Des techniques comme t-SNE ou UMAP projettent les embeddings en 2D pour les voir. Mais on perd de l’information. Que garde-t-on, que perd-on ?

-

Les biais dans les embeddings : Si l’IA apprend sur des textes humains, elle apprend aussi nos préjugés. “Docteur - homme + femme” donne parfois “infirmière” au lieu de “docteure”. Comment nettoyer ces biais ?

-

Embeddings contextuels vs statiques : Dans un transformer, comment le contexte modifie-t-il exactement les coordonnées ? C’est le rôle du mécanisme d’attention, un sujet fascinant à explorer ensuite.

-

Au-delà des mots : On peut créer des embeddings pour des phrases, des paragraphes, des images, même des molécules chimiques. Qu’est-ce que ça change d’encoder des objets plus complexes ?

Vous avez maintenant les bases pour explorer ces territoires. L’arithmétique des mots n’est que le début d’un monde où le sens devient calculable.

Ressources Web

-

Illustrated Word2Vec par Jay Alammar : visualisations interactives exceptionnelles sur word2vec et les embeddings

https://jalammar.github.io/illustrated-word2vec/ -

Word Embedding Demo par Carnegie Mellon University : tutoriel interactif pour expérimenter avec les analogies de mots

https://www.cs.cmu.edu/~dst/WordEmbeddingDemo/tutorial.html

AiBrain

AiBrain