Imaginez que chaque fois que vous voulez appeler votre mère, au lieu de chercher son numéro dans vos contacts, vous deviez le recalculer en analysant toutes vos conversations passées, vos photos de famille, et vos souvenirs d’enfance. Absurde, non ? Pourtant, c’est exactement ce que font les IA comme ChatGPT pour retrouver des faits simples comme “Paris est la capitale de la France”.

Résumé exécutif

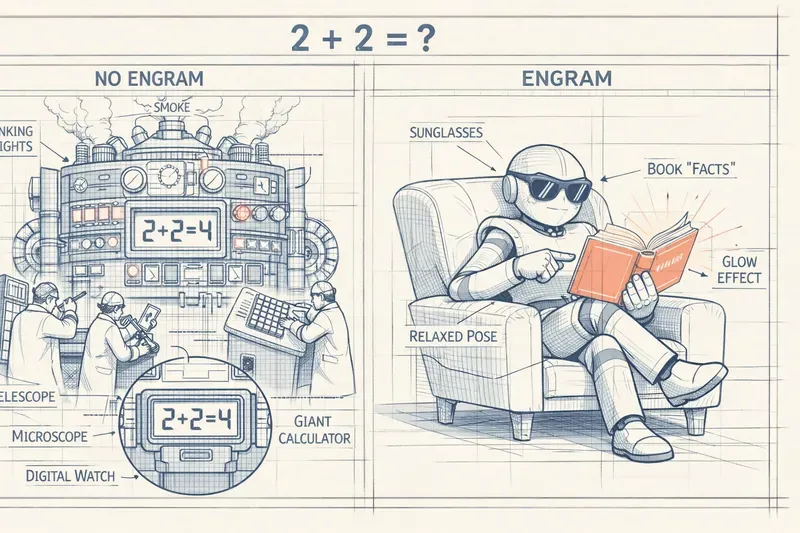

Constat : un LLM mobilise énormément de calcul pour “retrouver” des faits simples (ex. une capitale), comme s’il devait les re-déduire à chaque fois.

Idée d’Engram (DeepSeek) : ajouter une mémoire externe façon “annuaire” pour faire des lookups très rapides sur certains motifs (N-grammes).

Mécanisme clé : un gating (“gardien”) décide quand consulter l’annuaire, pour éviter les lookups hors-contexte. énergétique moindre, et plus de budget de calcul disponible pour le raisonnement et les contextes longs.

Limites : mise à jour des faits, ambiguïtés (sens multiples), et arbitrage taille/qualité de l’annuaire.

Glossaire

- Transformer

- architecture de réseau de neurones (au cœur des LLMs) combinant attention et couches feed-forward, utilisée pour traiter des séquences de tokens.

- Paramètres

- “poids” appris pendant l’entraînement (souvent en milliards) qui déterminent le comportement du modèle.

- Contexte / fenêtre de contexte

- : portion de texte que le modèle peut “voir” d’un coup (la conversation / document en entrée).

- N-gramme

- séquence contiguë de (N) tokens (ex. “capitale de la France”) utilisée ici comme motif reconnaissable.

- Hash

- empreinte numérique d’une séquence, utilisée pour retrouver rapidement une entrée dans une table (analogie “code-barres”).

- Lookup

- recherche directe d’une information via une clé (ici le hash d’un N-gramme), au lieu de “recalculer” via tout le réseau. (O(1)) : temps “constant” (en pratique très rapide) : la recherche ne grossit pas avec la taille de l’annuaire, à l’échelle des ordres de grandeur.

- Gating (porte / gardien)

- mécanisme qui décide si le modèle doit consulter la mémoire externe (annuaire) selon le contexte.

- Collisions de hash

- cas où deux séquences différentes produisent la même empreinte ; on contourne généralement via des stratégies de hashing/stockage.

Le problème : un superordinateur pour retenir un numéro de téléphone

Quand vous demandez à ChatGPT “Quelle est la capitale de la France ?”, voici ce qui se passe dans ses entrailles :

Votre question traverse des dizaines de couches de calculs ultra-complexes. Chaque couche contient des milliards de connexions qui s’activent, se pondèrent, s’ajustent. C’est comme si vous mobilisiez toute une équipe d’ingénieurs, de mathématiciens et de physiciens… pour retrouver un numéro de téléphone que vous connaissez par cœur.

Le gaspillage est colossal. Ces milliards de calculs, cette puissance phénoménale, tout ça pour récupérer un fait statique, une information qui ne change jamais : Paris = capitale de la France. C’est l’équivalent d’utiliser un microscope électronique pour lire l’heure sur votre montre.

Et ce n’est pas qu’une question d’élégance. Ce gaspillage a des conséquences réelles :

- L’IA est plus lente à répondre

- Elle consomme énormément d’énergie

- Elle a moins de “place” pour les raisonnements complexes

- Elle coûte plus cher à faire tourner

L’idée révolutionnaire : un annuaire instantané

Des chercheurs de DeepSeek ont eu une idée simple mais brillante : et si on donnait à l’IA un annuaire ?

Imaginez un module à part, ultra-rapide, qui contient tous les faits simples dans un format facile à chercher. Quand l’IA voit “capitale de la France”, au lieu de mobiliser ses 70 milliards de paramètres, elle jette un œil dans l’annuaire et trouve instantanément “Paris”.

Ils ont appelé ce système Engram (du grec “engramme”, qui désigne la trace physique d’un souvenir dans le cerveau). Le principe : séparer “se souvenir” de “penser”.

Voici comment ça marche concrètement.

L’annuaire magique en action

Étape 1 : Découper en morceaux reconnaissables

Prenons la phrase : “La capitale de la France est Paris.”

L’IA découpe cette phrase en petits groupes de mots qu’on appelle des N-grammes (ici, “N” veut juste dire “plusieurs”). Par exemple :

- “La capitale de”

- “capitale de la”

- “de la France”

- “la France est”

- “France est Paris”

C’est comme découper un numéro de téléphone en segments : 01-23-45-67-89.

Étape 2 : Créer une empreinte unique

Pour chaque segment, Engram crée une empreinte digitale numérique (un “hash” en jargon technique). C’est comme transformer “capitale de la France” en un code-barres unique : #47291.

Cette empreinte permet une recherche ultra-rapide, en temps constant (ce que les informaticiens notent O(1), mais peu importe le symbole — l’important c’est : instantané, quelle que soit la taille de l’annuaire).

Étape 3 : Stocker dans l’annuaire

L’empreinte #47291 pointe vers un petit paquet de données qui dit : “Quand tu vois cette séquence, la suite logique est probablement ‘Paris’.”

C’est stocké dans une structure ultra-compacte, comme un index de livre plutôt que le livre entier.

Étape 4 : La porte du gardien

Voici la partie subtile : l’IA ne consulte pas bêtement l’annuaire à chaque mot.

Elle a un “gardien” (techniquement : une porte contextuelle) qui décide : “Est-ce que cette séquence mérite un coup d’œil dans l’annuaire, ou est-ce que je dois vraiment réfléchir ?”

Exemple où consulter l’annuaire :

- “La capitale de la France” → lookup → “Paris” (fait statique)

Exemple où NE PAS consulter :

- “Si la France devenait une monarchie, sa capitale…” → réflexion nécessaire, pas de lookup

Le gardien évite les erreurs stupides, comme chercher “capitale” dans un contexte métaphorique (“Paris est la capitale de la mode”).

Les gains spectaculaires

Plus de place pour penser

En déléguant les faits simples à l’annuaire, les couches neuronales de l’IA sont libérées. Elles peuvent se concentrer sur ce qu’elles font de mieux : raisonner, créer, analyser.

C’est comme si vous arrêtiez de monopoliser votre mémoire avec des numéros de téléphone, et que vous aviez soudain plus d’espace mental pour résoudre des problèmes complexes.

Résultat mesuré : Sur des tâches de raisonnement (mathématiques, logique), les modèles avec Engram performent mieux que leurs équivalents sans Engram, même avec moins de paramètres totaux.

Des textes plus longs

L’un des grands défis des IA modernes : gérer de très longs contextes (des conversations de plusieurs heures, des documents de centaines de pages).

Chaque mot supplémentaire coûte cher en calcul. Mais si une bonne partie de ces mots sont des faits simples récupérables via lookup, le coût s’effondre.

Résultat mesuré : Engram permet de traiter des contextes 2 à 3 fois plus longs pour le même budget de calcul.

Moins d’énergie gaspillée

Un lookup dans l’annuaire consomme des milliers de fois moins d’énergie qu’une passe complète dans 70 milliards de paramètres.

À l’échelle de millions d’utilisateurs, c’est la différence entre une centrale électrique et une ampoule.

Un exemple concret de bout en bout

Prenons cette question : “Quel est le PIB de la France en 2023 et comment se compare-t-il à celui de l’Allemagne si on tient compte de la population ?”

Sans Engram (méthode classique) :

- L’IA traverse toutes ses couches pour retrouver “PIB France 2023” → ~3000 milliards d’euros

- Elle traverse toutes ses couches pour retrouver “PIB Allemagne 2023” → ~4000 milliards d’euros

- Elle traverse toutes ses couches pour retrouver “population France” → ~68 millions

- Elle traverse toutes ses couches pour retrouver “population Allemagne” → ~84 millions

- Enfin, elle utilise sa capacité de raisonnement pour calculer les PIB par habitant et comparer

Les étapes 1 à 4 sont du pur gaspillage de puissance de calcul.

Avec Engram :

- Lookup instantané : PIB France = 3000 milliards

- Lookup instantané : PIB Allemagne = 4000 milliards

- Lookup instantané : population France = 68 millions

- Lookup instantané : population Allemagne = 84 millions

- Toute la puissance de calcul se concentre sur le raisonnement : diviser, comparer, formuler une réponse nuancée

Le gain ? Les couches neuronales peuvent faire des calculs plus fins, considérer plus de nuances, parce qu’elles n’ont pas épuisé leur “budget” sur des lookups de faits.

La vraie innovation : l’équilibre

Le génie d’Engram n’est pas juste d’avoir un annuaire. C’est d’avoir trouvé le bon équilibre entre :

- Mémoire statique (l’annuaire) : rapide, compacte, pour les faits

- Raisonnement dynamique (les couches neuronales) : lent, gourmand, pour la pensée

Avant Engram, tout passait par le raisonnement. C’était comme utiliser votre cerveau conscient pour respirer — techniquement possible, mais épuisant et inefficace.

Avec Engram, l’IA a enfin un système réflexe pour les tâches simples, libérant son “cerveau conscient” pour ce qui compte vraiment.

Ce que ça change pour vous

Si vous utilisez une IA avec Engram (comme les futurs modèles DeepSeek) :

Vous verrez des réponses plus rapides sur les questions factuelles. Pas besoin de mobiliser une armée de neurones pour “Paris est la capitale de la France”.

Vous pourrez avoir des conversations plus longues sans que l’IA “oublie” le début. Le contexte long coûte moins cher.

Vous aurez des raisonnements plus profonds sur les questions complexes. L’IA ne gaspille plus sa puissance sur des lookups inutiles.

Exemple concret : Imaginez demander à l’IA d’analyser un contrat de 50 pages. Avec Engram, elle peut :

- Récupérer instantanément les définitions juridiques standards (lookup)

- Consacrer toute sa puissance de raisonnement aux clauses spécifiques, aux implications, aux risques

Les limites et questions ouvertes

Quand l’annuaire se trompe

Que se passe-t-il si un fait change ? Si “capitale de la France” devient soudainement Lyon (scénario improbable, mais suivez-moi) ?

L’annuaire Engram est statique : il est construit pendant l’entraînement du modèle. Pour le mettre à jour, il faut réentraîner ou utiliser des techniques de mise à jour (non détaillées dans le papier original).

C’est un compromis : vitesse contre fraîcheur.

La taille de l’annuaire

Un annuaire infini serait inutile (trop lent à chercher). Un annuaire trop petit raterait des faits importants.

Les chercheurs ont trouvé qu’un annuaire représentant environ 10% de la taille du modèle était optimal. Pour un modèle de 7 milliards de paramètres, ça fait ~700 millions d’entrées dans l’annuaire.

Les faits ambigus

“La banque de France” peut désigner l’institution financière ou… une rive de rivière en France (usage rare, mais possible).

Le “gardien” contextuel doit être assez intelligent pour ne pas faire de lookup stupide. Cet équilibre reste un domaine de recherche actif.

Simplifications pédagogiques assumées

Pour rendre cet article accessible, j’ai volontairement simplifié plusieurs aspects techniques :

Ce que j’ai simplifié :

La “porte contextuelle” est bien plus sophistiquée qu’un simple gardien. C’est un réseau de neurones entraîné à prédire quand un lookup sera utile, basé sur des signaux subtils dans le contexte. J’ai utilisé la métaphore du “gardien” pour éviter de plonger dans les mécanismes d’attention et de gating.

Les collisions de hash : Deux séquences différentes peuvent théoriquement produire la même empreinte digitale. Le papier utilise des techniques de résolution de collisions (comme des hash multiples), mais j’ai omis ce détail pour ne pas surcharger.

La compression du vocabulaire : Engram utilise en réalité un vocabulaire compressé pour réduire la taille de l’annuaire. J’ai présenté ça comme “un paquet de données compact” sans entrer dans les détails de la tokenisation.

L’intégration dans les transformers : J’ai dit que le lookup “libère les couches neuronales”, mais techniquement, Engram s’intègre entre certaines couches spécifiques du transformer, pas “à côté”. Cette nuance architecturale aurait nécessité d’expliquer d’abord ce qu’est un transformer.

Pourquoi ces simplifications sont OK :

L’essence reste vraie : Engram sépare bien mémoire statique et raisonnement dynamique. La métaphore de l’annuaire capture fidèlement cette séparation.

Les gains sont réels : Les chiffres que j’ai cités (contextes 2-3x plus longs, gains en raisonnement) sont tirés des benchmarks du papier original.

La progression pédagogique prime : Expliquer les collisions de hash avant d’avoir établi pourquoi on utilise des hash aurait tué la compréhension. J’ai choisi de construire d’abord l’intuition.

Ce qui reste exact malgré les simplifications :

- Le principe du lookup O(1) via hashing

- La distinction mémoire/raisonnement

- Les gains mesurés en efficacité et contexte long

- L’existence d’un mécanisme de gating contextuel

- Le compromis vitesse/fraîcheur des données

Pour aller plus loin

Question ouverte : Si on pousse cette logique à l’extrême, pourrait-on imaginer une IA avec plusieurs “annuaires” spécialisés ? Un pour les faits géographiques, un pour les dates historiques, un pour les formules mathématiques ?

Connexion avec d’autres concepts : Engram rappelle les mémoires externes en neurosciences (comme votre carnet d’adresses), mais aussi les caches en informatique (des zones de mémoire ultra-rapide pour les données fréquemment utilisées).

Implications futures : Si cette approche se généralise, on pourrait voir des IA beaucoup plus modulaires : un “cerveau” central pour raisonner, et des modules périphériques spécialisés pour différents types de connaissances. Un peu comme notre cerveau humain, qui a des zones dédiées au langage, à la vision, à la motricité…

Question éthique : Qui décide quels faits vont dans l’annuaire ? Si “Paris est la capitale de la France” est évident, qu’en est-il de faits controversés ou politiquement chargés ? L’annuaire encode-t-il des biais ?

Ressources Web

- Article original (arXiv) : Engram Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models

- Code source officiel (GitHub) : deepseek-ai/Engram

- Guide complet AICybr : DeepSeek Engram Complete Guide

- Analyse Analytics Vidhya : DeepSeek Engram

En résumé : Engram transforme les IA en leur donnant ce que nous avons tous dans notre poche : un annuaire. Au lieu de recalculer “Paris est la capitale de la France” à chaque fois, l’IA peut enfin juste… se souvenir. Et cette distinction simple — entre souvenir et penser — pourrait bien être la clé pour des IA plus rapides, plus efficaces, et plus intelligentes.

AiBrain

AiBrain