Pourquoi « review ce code » et « review ce code pour la sécurité » ne donnent pas les mêmes résultats

Résumé exécutif

Constat : Un même code avec une faille de sécurité évidente (ex. injection SQL) peut être détecté ou ignoré selon la formulation du prompt. « Review ce code » peut rater la faille, tandis que « Review ce code pour la sécurité » la détecte systématiquement.

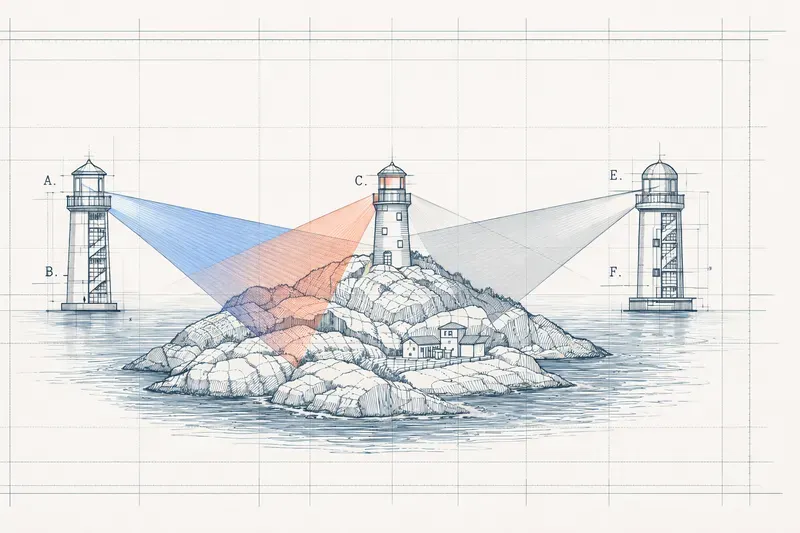

Hypothèse centrale : Le prompt ne change pas seulement ce qu’on demande, il oriente où le modèle cherche. Dans l’architecture transformer, le mécanisme de multi-head attention permet d’observer le même input sous plusieurs angles. Le prompt fonctionne comme une orientation de regard qui guide l’exploration plutôt qu’un simple filtre.

Recherche récente : Les travaux sur les modèles de raisonnement (DeepSeek-R1, QwQ-32B) montrent que la performance émerge de la diversification interne des perspectives — une “société de pensée” qui émerge naturellement quand on optimise pour la précision.

Implication pour le design d’agents : La vraie question n’est pas “combien d’agents ?” mais “combien de perspectives distinctes ?”. Un multi-agent bien conçu est un ensemble sur l’espace des perspectives, pas du parallélisme cosmétique.

Conclusion : Un LLM n’est pas un oracle, c’est un explorateur biaisé. Le prompt est un biais d’exploration. La vérité n’est pas un point, c’est une silhouette qui n’apparaît que lorsque suffisamment de projections se chevauchent.

Glossaire

- Multi-head attention

- mécanisme central des Transformers qui permet d’observer le même input sous plusieurs angles simultanément. Chaque “tête” d’attention capte des relations différentes : syntaxiques, sémantiques, structurelles, contextuelles.

- Transformer

- architecture de réseau de neurones (au cœur des LLMs) combinant attention multi-head et couches feed-forward, utilisée pour traiter des séquences de tokens.

- Prompt engineering

- art et science de formuler des instructions pour guider le comportement d’un LLM. Un bon prompt oriente l’exploration plutôt que de simplement décrire la tâche.

- Attention routing (orientation de l’attention)

- concept selon lequel le prompt oriente où le modèle cherche dans son espace de connaissances, plutôt que de filtrer après coup.

- Society of Thought

- phénomène observé dans les modèles de raisonnement où la performance émerge de la diversification interne des perspectives — le modèle simule des dialogues internes entre angles d’analyse différents.

- KV cache

- mécanisme qui permet la réutilisation de calculs dans les LLMs, optimisant l’efficacité mais pouvant ancrer le modèle dans sa trajectoire initiale.

- Multi-agent homogène

- système utilisant le même modèle avec des prompts différents, créant de la valeur par l’échantillonnage de trajectoires plutôt que par le parallélisme.

- Multi-agent hétérogène

- système utilisant des modèles différents, bénéficiant de biais différents, zones aveugles différentes et styles cognitifs différents.

- OneFlow

- approche montrant qu’un agent unique en multi-tour peut égaler des systèmes multi-agents sur certains benchmarks, mais avec un angle mort structurel : le même mécanisme qui optimise l’efficacité ancre le modèle dans sa trajectoire initiale.

L’observation qui dérange

Prenez un bout de code avec une faille de sécurité évidente — une injection SQL, par exemple. Demandez à Claude ou GPT :

« Review ce code »

Vous obtenez des commentaires sur la lisibilité, la structure, parfois les conventions de nommage. La faille ? Parfois mentionnée, parfois non.

Même code, même modèle :

« Review ce code pour les vulnérabilités de sécurité »

La faille apparaît en premier. Avec des détails. Et d’autres problèmes que le premier review n’avait pas vus.

Pourtant, dans les deux cas, on “review” le même code.

La sécurité devrait être une préoccupation primaire d’un bon review.

Pourquoi le modèle ne la voit-il pas systématiquement ?

Le prompt n’est pas une instruction, c’est un projecteur

Mon hypothèse : quand vous changez le prompt, vous ne changez pas seulement ce que vous demandez. Vous changez où le modèle cherche.

Dans l’architecture transformer, le mécanisme de multi-head attention permet au modèle d’observer le même input sous plusieurs angles. Chaque tête capte des relations différentes : syntaxiques, sémantiques, structurelles, contextuelles.

Le prompt fonctionne comme une orientation de regard :

- « Review ce code » oriente vers des patterns de qualité générale (lisibilité, structure, conventions).

- « Review ce code pour la sécurité » oriente vers des patterns de menace (validation d’inputs, frontières de confiance, flux d’authentification, surfaces d’attaque).

⚠️ Il ne s’agit pas d’un lien causal mécanistique entre prompt et têtes d’attention, mais d’un pont sémantique : dans les deux cas, on retrouve le même principe fondamental — la multiplication des points de vue comme stratégie de compréhension.

Le modèle ne « voit » pas tout puis ne filtre pas ensuite.

Il explore selon un angle donné.

Ce que la recherche récente confirme

Society of Thought : la diversité émerge naturellement

Les travaux sur les modèles de raisonnement (DeepSeek-R1, QwQ-32B, etc.) montrent que la performance ne vient pas d’un raisonnement linéaire unique, mais de la diversification interne des perspectives.

Les modèles simulent des dialogues internes entre angles d’analyse différents — une “société de pensée”.

Ce comportement n’est pas programmé :

il émerge quand on optimise pour la précision.

Le système apprend que diversifier les angles améliore la qualité des résultats.

OneFlow : les limites de l’agent unique

OneFlow montre qu’un agent unique en multi-tour peut égaler des systèmes multi-agents sur plusieurs benchmarks.

Argument principal :

- le KV cache permet la réutilisation de calculs,

- l’efficacité est supérieure,

- la coordination est plus simple.

Mais il existe un angle mort structurel :

Le même mécanisme qui optimise l’efficacité ancre le modèle dans sa trajectoire initiale.

Quand le même agent joue successivement writer puis critic, il reste prisonnier de son propre cheminement.

Un critic réellement externe, sans accès au contexte de génération, part d’un autre point de départ cognitif.

Les benchmarks mesurent la justesse de réponse.

Ils ne mesurent pas la couverture de l’espace des problèmes possibles.

L’implication pour le design d’agents

La vraie question n’est pas :

combien d’agents ?

Mais :

combien de perspectives distinctes ?

Multi-agent homogène

Même modèle, prompts différents :

- valeur créée par l’échantillonnage de trajectoires

- pas par le parallélisme

Multi-agent hétérogène

Modèles différents :

- biais différents

- zones aveugles différentes

- styles cognitifs différents

Claude ne rate pas les mêmes choses que GPT.

Le multi-agent bien conçu n’est pas du parallélisme cosmétique.

C’est un ensemble sur l’espace des perspectives.

Quand ça compte, quand ça ne compte pas

| Type de tâche | Nature | Stratégie optimale |

|---|---|---|

| Question factuelle | Convergente | Agent unique |

| Calcul déterministe | Convergente | Agent unique |

| Transformation de données | Convergente | Agent unique |

| Review de code | Exploratoire | Multi-perspectives |

| Analyse de risque | Exploratoire | Multi-perspectives |

| Sécurité | Exploratoire | Multi-perspectives |

| Création | Exploratoire | Multi-perspectives |

| Détection d’anomalies | Exploratoire | Multi-perspectives |

Prompt engineering = attention routing (au sens conceptuel)

Un bon prompt ne décrit pas seulement la tâche.

Il oriente la recherche.

« Tu es un expert en sécurité » n’est pas du roleplay cosmétique.

C’est une instruction de perspective :

cherche dans les patterns de raisonnement sécurité,

pas dans les patterns généraux.

Les personas, system prompts, rôles, instructions :

- ne servent pas à théâtraliser,

- servent à orienter l’espace exploré.

Épistémologie

| Niveau | Mécanisme |

|---|---|

| Architecture | Multi-head attention = pluralité de regards |

| Inférence | Prompt = orientation de l’exploration |

| Agent design | Multi-agent = diversification des trajectoires |

| Épistémologie | Pas de vérité globale, seulement des projections |

Nietzsche écrivait qu’il n’y a pas de vérité absolue, seulement des perspectives.

Les transformers ont intégré ce principe, non comme une thèse philosophique, mais comme une contrainte d’ingénierie :

multiplier les points de vue plutôt que chercher une représentation unique.

Peut-être que le meilleur design d’agent n’est pas celui qui cherche la bonne réponse,

mais celui qui multiplie les angles,

jusqu’à ce qu’une forme stable émerge de leurs recouvrements.

Conclusion

Un LLM n’est pas un oracle.

C’est un explorateur biaisé.

Le prompt est un biais d’exploration.

Le multi-agent est une stratégie de couverture.

La vérité n’est pas un point.

C’est une silhouette,elle n’apparaît que lorsque suffisamment de projections se chevauchent.

Articles connexes :

- 8 Projecteurs Pour Lire une phrase : Comment un LLM comprend votre message

- Recette LLM façon GPT : l’architecture expliquée

- Méta-analyse des capacités des agents IA

Références

- Reasoning Models Generate Societies of Thought

https://arxiv.org/abs/2601.10825?utm_source=substack&utm_medium=email - Rethinking the Value of Multi-Agent Workflow: A Strong Single Agent Baseline (OneFlow)

- https://arxiv.org/abs/2601.12307?utm_source=substack&utm_medium=email

AiBrain

AiBrain