Résumé Exécutif

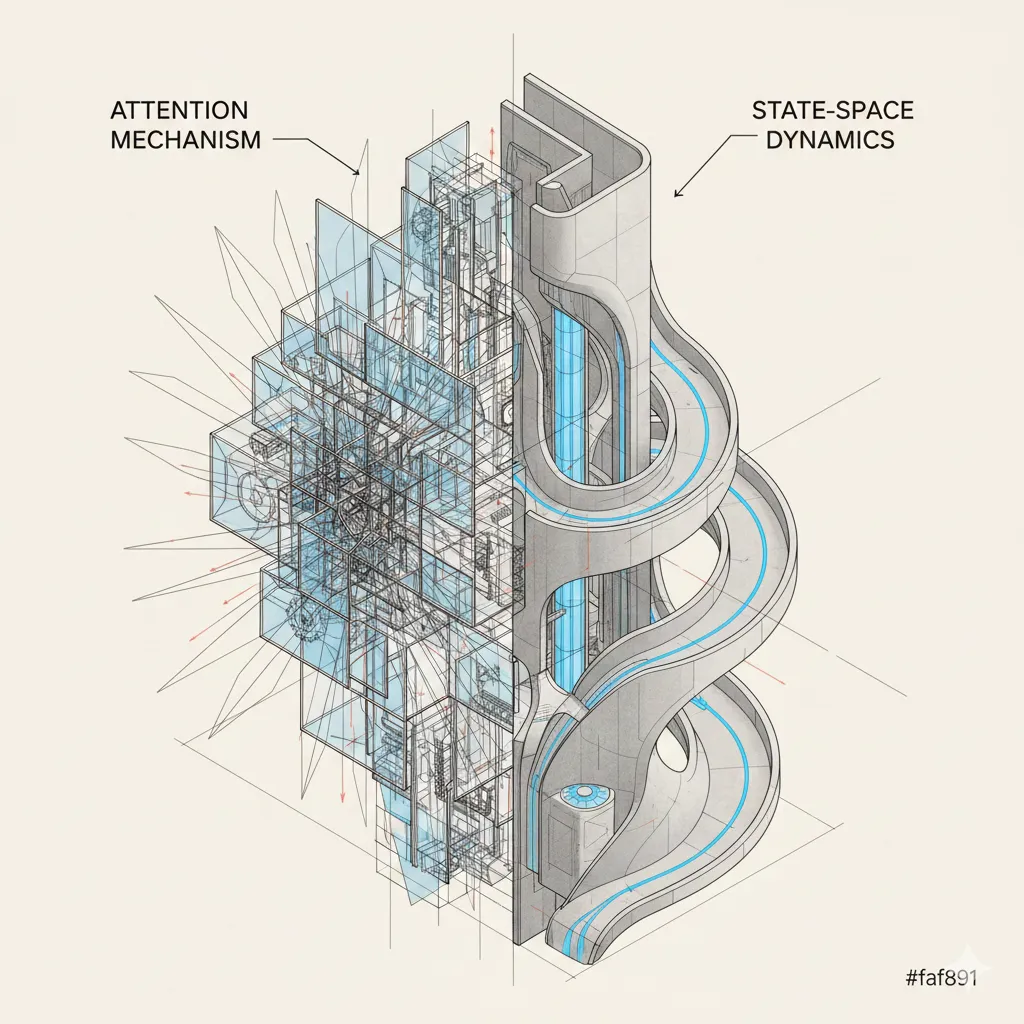

Le Contexte : Depuis 2017, le mécanisme d’attention des Transformers règne en maître absolu, propulsant la révolution des LLMs. Pourtant, malgré sa puissance, son coût en mémoire GPU (le fameux cache KV) devient un goulet d’étranglement insurmontable pour les contextes très longs. Des alternatives comme les State-Space Models (SSM) existaient en laboratoire, mais restaient jusqu’ici incapables d’égaler la précision des Transformers.

La Rupture 2025 : Le paysage change. Nous sortons de l’ère du “Transformer pour tout” pour entrer dans celle des architectures hybrides.

-

Hybridation massive : Des modèles comme Jamba ou Bamba fusionnent désormais l’Attention et les SSM, offrant un débit d’inférence jusqu’à 3x supérieur tout en gérant des fenêtres de 256k tokens.

-

Optimisation interne : Le Gated Attention (meilleur papier NeurIPS 2025) prouve que l’architecture classique peut encore être simplifiée et stabilisée avec des modifications minimales.

L’Enjeu : Ce n’est pas la mort des Transformers, mais la fin de leur monopole. En 2025, le choix de l’architecture devient une décision stratégique : privilégier l’efficacité hybride pour le traitement de masse, ou la robustesse du Transformer pur pour le raisonnement critique et le code.

Glossaire : comprendre les termes techniques

- Transformer / Attention

- Architecture de réseau de neurones introduite en 2017 qui utilise un mécanisme d’attention pour comprendre les relations entre les mots d’une séquence. L’attention permet au modèle de “regarder” tous les tokens précédents pour générer le suivant. C’est la base de GPT, Claude, Llama et la plupart des LLMs actuels. L’attention est puissante mais coûteuse en mémoire : elle doit stocker l’historique complet de la séquence.

- SSM (State Space Model)

- Architecture alternative aux Transformers qui modélise les séquences via un état caché constant plutôt qu’un historique complet. Au lieu de stocker tous les tokens précédents en mémoire, un SSM maintient un état compressé qui évolue séquentiellement. Avantage : complexité linéaire en longueur de séquence (vs quadratique pour l’attention). Inconvénient : perte d’accès explicite à l’historique complet.

- Mamba

- Architecture SSM spécifique développée en 2023 qui utilise des mécanismes de sélection pour décider quelles informations garder dans l’état caché. Mamba-2 est une version améliorée. Ces modèles excellent sur les séquences très longues (256k+ tokens) mais peinent sur les tâches nécessitant un rappel précis d’informations distantes.

- Cache KV (Key-Value)

- Mécanisme de stockage utilisé par les Transformers pendant la génération. Pour chaque token généré, le modèle calcule et stocke des paires clé-valeur qui représentent l’information contextuelle. Ce cache grandit linéairement avec la longueur de la séquence, ce qui limite la taille du contexte. Les SSM n’ont pas besoin de ce cache, d’où leur avantage mémoire.

- Gated Attention

- Innovation récompensée par le Best Paper Award à NeurIPS 2025. Ajoute une porte sigmoïde après chaque tête d’attention pour introduire de la non-linéarité et de la sparsité. Réduit les “attention sinks” (tokens qui accumulent artificiellement de l’attention) et améliore la stabilité d’entraînement. Modification minimale qui s’intègre facilement dans les Transformers existants.

- Mixture-of-Experts (MoE)

- Architecture où seuls certains “experts” (sous-réseaux) sont activés pour chaque token, réduisant le coût computationnel. Un modèle de 52 milliards de paramètres peut n’avoir que 12 milliards actifs à l’inférence. Utilisé dans Jamba et d’autres modèles hybrides pour combiner efficacité et capacité.

- Apprentissage en contexte (in-context learning)

- Capacité d’un modèle à apprendre à partir d’exemples fournis dans le prompt sans mise à jour des poids. Par exemple, donner 5 exemples de traduction français-anglais dans le prompt, puis demander de traduire une nouvelle phrase. Les Transformers excellent sur cette tâche, les SSM purs y peinent car ils compressent l’information dans un état caché.

- Rappel associatif

- Capacité à récupérer des informations spécifiques en fonction de leur relation avec d’autres éléments. Par exemple, se souvenir qu’un personnage mentionné au début d’un long texte est “le médecin” quand on le mentionne à nouveau 10 000 tokens plus tard. Les Transformers maintiennent un accès explicite à tout l’historique via l’attention, les SSM doivent reconstruire cette information depuis leur état caché compressé.

Le débat sur la mort annoncée des Transformers refait surface à chaque nouvelle architecture. Depuis l’émergence de Mamba et des State Space Models (SSM) en 2023, les prédictions apocalyptiques se multiplient sur LinkedIn et dans les conférences tech. Pourtant, fin 2025, la réalité du terrain raconte une histoire plus nuancée. Les architectures hybrides qui combinent attention et SSM gagnent du terrain, mais pas pour les raisons qu’on imagine.

Les modèles comme Jamba d’AI21, Zamba2 de Zyphra, ou le récent Bamba d’IBM Research ne remplacent pas les Transformers. Ils les complètent dans des cas d’usage précis où l’efficacité compte plus que la performance brute. Les benchmarks de 2025 révèlent une segmentation claire : les hybrides excellent sur l’inférence longue et les contraintes mémoire, mais les architectures pures dominent encore sur les tâches exigeant du rappel associatif ou de l’apprentissage en contexte.

Cette distinction n’est pas anodine. Elle redéfinit comment nous choisissons nos architectures en production.

Mémoire dans les modèles de séquence : Explicite vs Dynamique vs Routée

L’efficacité ciblée des hybrides : promesses et réalité

Les architectures hybrides Attention-SSM promettent le meilleur des deux mondes : la capacité d’attention des Transformers et l’efficacité linéaire des SSM. Sur le papier, c’est séduisant. En pratique, les gains se concentrent sur des scénarios spécifiques.

Jamba, le modèle hybride d’AI21 lancé début 2024 et affiné en 2025, illustre cette approche. Avec 52 milliards de paramètres dont seulement 12 milliards actifs à l’inférence grâce à une architecture Mixture-of-Experts, il combine des couches Mamba et Transformer. Le résultat : une fenêtre de contexte de 256k tokens avec un débit d’inférence supérieur aux Transformers de taille équivalente. IBM Research a suivi une logique similaire avec Bamba, qui réduit la taille du modèle de 18 GB à 9 GB via quantisation 8-bit tout en maintenant des performances comparables à Llama-3.1 8B, pourtant entraîné sur sept fois plus de données.

Les gains d’efficacité sont réels et mesurables. Le Nemotron-H de NVIDIA, qui remplace 92% de ses couches d’attention par des blocs Mamba2, affiche un débit jusqu’à trois fois supérieur aux Transformers de taille similaire comme LLaMA-3.1 et Qwen-2.5. Cette accélération provient d’une caractéristique fondamentale des SSM : l’absence de cache clé-valeur. Là où un Transformer stocke en mémoire GPU l’historique complet de la séquence, le SSM maintient un état caché constant, quelle que soit la longueur du contexte.

Mais cette efficacité a un coût. Les recherches publiées en juillet 2025 dans “Characterizing State Space Model and SSM-Transformer Hybrid Language Model Performance with Long Context Length” montrent que les modèles Mamba et Mamba-2 purs accusent un retard significatif sur les benchmarks exigeant du rappel associatif fort ou de l’apprentissage en contexte, notamment le five-shot MMLU. Les hybrides comblent partiellement cet écart en réintroduisant des couches d’attention stratégiques, mais ne rattrapent pas les architectures pures.

Cette segmentation n’est pas un bug, c’est une caractéristique. Les hybrides optimisent pour des contraintes d’infrastructure et de latence, pas pour la performance absolue sur tous les benchmarks.

Gated Attention : l’amélioration incrémentale qui compte

Pendant que les hybrides SSM captent l’attention médiatique, une innovation plus discrète transforme les Transformers de l’intérieur. Le Gated Attention, récompensé par le Best Paper Award à NeurIPS 2025, représente exactement le type d’amélioration incrémentale qui fait la différence en production.

L’équipe Qwen d’Alibaba a démontré qu’une modification architecturale minimale – ajouter une porte sigmoïde spécifique à chaque tête d’attention après le Scaled Dot-Product Attention – améliore systématiquement les performances sur des modèles allant jusqu’à plusieurs milliards de paramètres. Cette simplicité est trompeuse. Les expériences montrent que cette porte introduit de la non-linéarité et de la sparsité dans l’attention, réduisant le phénomène d’attention sink où certains tokens accumulent artificiellement de l’attention sans raison sémantique.

Les résultats pratiques sont tangibles. Le Gated Attention améliore la stabilité d’entraînement des grands modèles de langage et facilite l’extension de contexte. Dans les tests d’extrapolation de 32k à 128k tokens avec YaRN, les modèles équipés de Gated Attention montrent une dégradation de performance moindre que les baselines. Ce n’est pas révolutionnaire, mais c’est exactement le type d’amélioration qui se compose : quelques points de perplexité en moins, une meilleure utilisation du contexte long, une stabilité accrue.

L’adoption rapide de cette technique s’explique par sa facilité d’implémentation. Contrairement aux architectures hybrides qui nécessitent de repenser l’entraînement et l’inférence, le Gated Attention s’intègre dans les pipelines existants avec des modifications mineures. Les équipes ML peuvent l’ajouter à leurs Transformers sans réécrire leurs kernels CUDA ou adapter leurs frameworks de serving.

Cette approche incrémentale contraste fortement avec le discours disruptif autour des SSM. Elle rappelle que l’amélioration des architectures existantes reste souvent plus pragmatique que leur remplacement complet.

Les benchmarks ne mentent pas : la supériorité des architectures pures

Les métriques de performance brute racontent une histoire claire en 2025. Sur les tâches exigeant du raisonnement complexe, du rappel précis ou de l’apprentissage few-shot, les Transformers purs maintiennent leur avance.

Le papier “Achilles’ Heel of Mamba” accepté en spotlight à NeurIPS 2025 identifie les limites fondamentales des SSM via des données synthétiques. Les architectures Mamba, malgré leur complexité linéaire et leurs performances impressionnantes sur les séquences longues, échouent systématiquement sur des tâches de copie et de rappel qui ne posent aucun problème aux Transformers. Cette faiblesse n’est pas un détail d’implémentation qu’on peut corriger avec plus de données ou un meilleur tuning. Elle découle de la structure même des SSM, qui compressent l’information dans un état caché fixe au lieu de maintenir un accès explicite à tout l’historique via l’attention.

Les résultats d’IBM Research sur Granite 4 confirment ce pattern. Leurs tests montrent que “les modèles SSM purs égalent ou dépassent les Transformers sur de nombreuses tâches, mais les modèles Mamba et Mamba-2 restent significativement en retrait sur les tâches nécessitant de fortes capacités de copie ou d’apprentissage en contexte”. Cette limitation apparaît notamment sur le five-shot MMLU, où les modèles doivent généraliser à partir d’exemples fournis dans le prompt.

Les architectures hybrides tentent de contourner ce problème en réinjectant des couches d’attention stratégiques. Jamba alterne blocs Mamba et Transformer. Zamba2 et Nemotron-H adoptent des stratégies similaires. Mais même avec cette approche, les hybrides n’atteignent pas systématiquement les scores des Transformers purs sur les benchmarks académiques standards. Ils égalisent sur certaines métriques, dépassent sur d’autres liées à l’efficacité, mais ne dominent pas uniformément.

Cette réalité oblige à repenser le débat. La question n’est pas “les SSM vont-ils remplacer les Transformers ?” mais “pour quels cas d’usage les compromis des hybrides sont-ils acceptables ?”. Un chatbot traitant des conversations de plusieurs dizaines de milliers de tokens bénéficie clairement de l’efficacité mémoire des SSM. Un modèle de raisonnement complexe sur des tâches mathématiques ou de code a besoin de la capacité d’attention complète.

Le cas d’usage dicte l’architecture, pas l’inverse

La segmentation observée en 2025 pousse les équipes ML à inverser leur processus de décision architecturale. Plutôt que de choisir la dernière architecture à la mode et d’adapter les cas d’usage, les praticiens partent des contraintes métier pour sélectionner la bonne approche.

Les applications de traitement de documents longs – analyse juridique, synthèse médicale, revue de code – tirent avantage des hybrides SSM-Attention. La capacité à traiter des contextes de 128k ou 256k tokens sans exploser la mémoire GPU change fondamentalement l’économie de ces cas d’usage. IBM positionne explicitement ses modèles Granite 4 avec architecture hybride Mamba-2 pour “réduire les coûts d’inférence en entreprise” plutôt que pour battre des records sur les benchmarks académiques.

À l’inverse, les tâches de raisonnement complexe, de génération de code ou de question-answering multi-hop continuent de favoriser les Transformers purs. Les modèles de la famille GPT-4, Claude ou Llama maintiennent des architectures Transformer complètes précisément parce que leurs cas d’usage principaux exigent ce rappel associatif fort que les SSM peinent à reproduire.

Cette distinction apparaît également dans les choix d’optimisation. Le Gated Attention de Qwen améliore les Transformers existants sans changer leur nature fondamentale. C’est une évolution, pas une révolution. Les équipes qui ont déjà investi dans l’infrastructure Transformer – kernels optimisés, pipelines d’entraînement, outils de debugging – peuvent adopter ces améliorations incrémentales sans tout reconstruire.

Le framework “Unified Factorized Framework” proposé dans le papier “How Many Heads Make an SSM?” publié en décembre 2025 tente de formaliser ces compromis. Il représente attention et SSM comme des instances d’un même opérateur d’interaction dépendant de l’input, avec deux patterns de construction distincts : mixing explicite style attention, et dynamique structurée style state-space. Cette unification théorique suggère que le choix entre les deux n’est pas binaire mais dépend des propriétés de la tâche.

Les équipes qui réussissent en 2025 sont celles qui testent empiriquement plutôt que de suivre les tendances. Elles benchmarkent leurs cas d’usage réels sur plusieurs architectures et choisissent en fonction des métriques qui comptent pour leur produit : latence P99, coût par million de tokens, qualité sur leurs données privées. Les leaderboards publics sur MMLU ou HumanEval informent ces décisions mais ne les dictent pas.

L’évolution plutôt que la révolution

Le discours sur la “fin des Transformers” repose sur une incompréhension fondamentale de comment évoluent les architectures en production. Les révolutions architecturales sont rares. Les améliorations incrémentales composées sur plusieurs années sont la norme.

Les Transformers de 2025 ne ressemblent plus à ceux de 2017. Grouped-Query Attention réduit la taille du cache KV. Multi-Query Attention accélère le décodage. Flash Attention optimise l’utilisation de la mémoire GPU. Le Gated Attention améliore la stabilité et réduit les attention sinks. Ces modifications s’empilent pour produire des gains substantiels sans changer le paradigme fondamental.

Les architectures hybrides SSM-Attention s’inscrivent dans cette logique évolutive. Elles ne “tuent” pas les Transformers, elles élargissent l’espace des solutions disponibles. Pour certains cas d’usage – traitement de séquences ultra-longues sous contraintes mémoire – elles deviennent le choix optimal. Pour d’autres – raisonnement complexe, apprentissage few-shot – les Transformers purs restent supérieurs.

Cette coexistence est saine. Elle force les chercheurs à clarifier les compromis plutôt que de promettre des solutions universelles. Elle pousse les praticiens à mesurer empiriquement plutôt qu’à adopter aveuglément. Elle crée une pression compétitive qui bénéficie aux deux approches.

Les travaux théoriques récents, comme l’analyse de complexité computationnelle montrant que Mamba et Transformers résident dans la même classe DLOGTIME-uniform TC⁰, suggèrent une équivalence fondamentale malgré les différences architecturales. Cette convergence théorique renforce l’idée que le choix entre architectures relève plus de l’ingénierie – profil de mémoire, latence, facilité d’implémentation – que de capacités expressives fondamentalement différentes.

L’industrie ML mature. Elle sort progressivement de la phase “hype cycle” où chaque nouvelle architecture promet de tout révolutionner, pour entrer dans une phase d’optimisation pragmatique où le choix architectural devient une variable d’ingénierie parmi d’autres. Les Transformers ne disparaissent pas en 2025. Ils évoluent, se spécialisent, et cohabitent avec des alternatives optimisées pour d’autres contraintes.

La vraie question pour les équipes tech n’est pas “quelle architecture va gagner ?” mais “quels compromis sont acceptables pour nos cas d’usage ?”. Et cette question, aucun benchmark académique ne peut y répondre à notre place.

Comparaison rapide

| Aspect | Transformer | SSM | Hybride |

|---|---|---|---|

| Mémoire | O(n · d) | O(d_state) | O(n_local) + O(d_state) |

| Rappel | exact | implicite | ciblé |

| Streaming | faible | natif | bon |

Ressources Web

- IBM Research - Bamba: SSM-Transformer Hybrid Model

- AI21 - Announcing Jamba Architecture

- Characterizing SSM and Hybrid Model Performance with Long Context (arXiv)

- NeurIPS 2025 Best Paper Awards - Gated Attention

- Gated Attention for Large Language Models (OpenReview)

- InfoQ - IBM Granite 4 Hybrid Mamba-2 Architecture

- AI21 - Attention Was Never Enough: Rise of Hybrid LLMs

- Understanding Mamba-Transformer Hybrids (arXiv)

- Achilles’ Heel of Mamba (arXiv)

- How Many Heads Make an SSM? Unified Framework (arXiv)

AiBrain

AiBrain